Ascend C:PRelu算子自定义,轻松驾驭!

Ascend C 自定义PRelu算子:探索深度学习中的激活函数

在深度学习的广阔天地中,激活函数扮演着至关重要的角色。它们不仅为神经网络带来了非线性特性,还影响着模型的学习效率和泛化能力。今天,我们就来聊聊一个备受关注的激活函数——PReLU(Parametric Rectified Linear Unit),并通过Ascend C来探索如何自定义这样的算子。

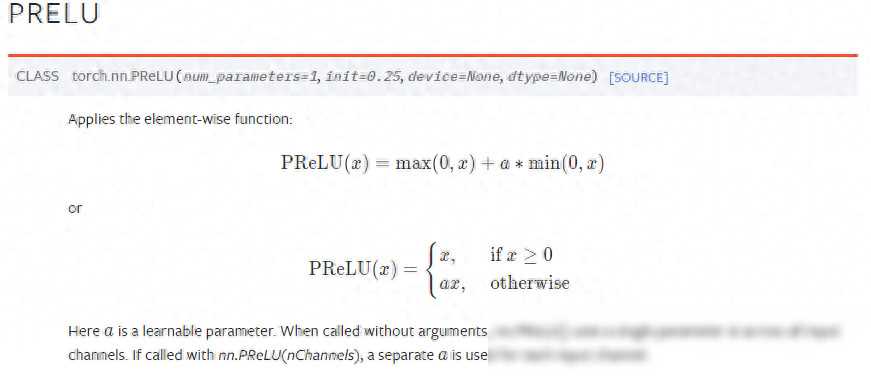

PReLU,即参数化修正线性单元,由何凯明团队提出,是ReLU(Rectified Linear Unit)的一种改进形式。在深度学习中,ReLU因其计算简单、效率高而广受欢迎,但它在处理负数输入时直接将其置零,可能会导致一些神经元“死亡”,即永远不会被激活。而PReLU则通过在负数区域引入一个可学习的斜率参数,使得神经元在输入为负时仍有机会被激活,从而增强了模型的拟合能力,并减小了过拟合的风险。

Ascend C是华为推出的面向昇腾AI处理器的编程框架,它提供了丰富的算子库和高效的计算性能,支持开发者进行深度学习模型的训练和推理。当我们需要在Ascend C中自定义算子时,就需要利用到它的算子开发工具链。

在开始自定义算子之前,我们需要确保已经安装了与Ascend C兼容的驱动、固件以及开发者套件。这些工具链为我们提供了从算子描述到代码生成的完整流程支持。

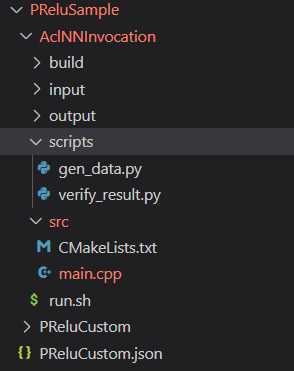

我们首先需要创建一个描述文件的模板,这个文件将包含算子的基本信息、输入输出描述以及计算逻辑等。在这个模板中,我们可以定义PReLU算子的参数(如斜率alpha),以及如何处理输入数据。

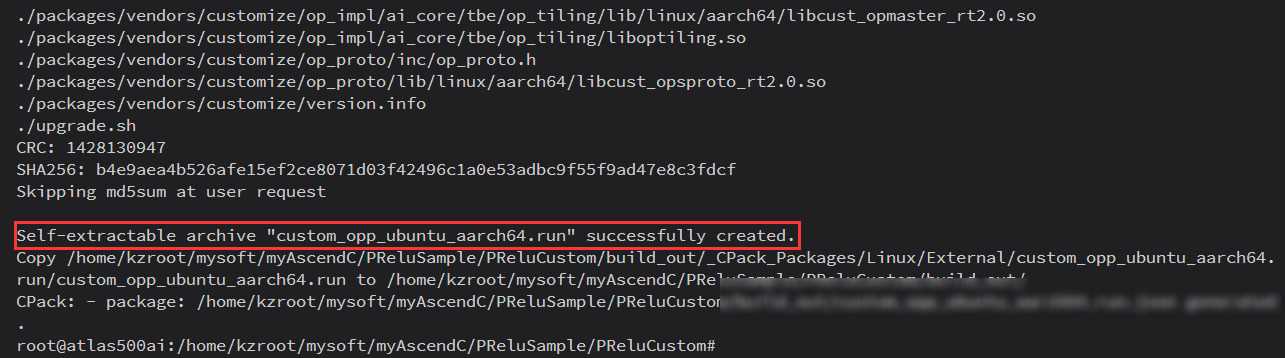

有了算子描述文件后,我们就可以利用Ascend C提供的算子生成工具(如msopgen),根据描述文件自动生成算子的代码框架。这个过程会生成包括头文件、源文件以及CMake配置文件在内的多个文件。

生成的代码框架中包含了算子计算的核心逻辑框架,但具体的实现细节还需要我们根据PReLU的数学表达式来填充。在这个过程中,我们需要考虑如何高效地处理输入数据,以及如何处理可能出现的特殊情况(如输入为空、输入数据类型不匹配等)。

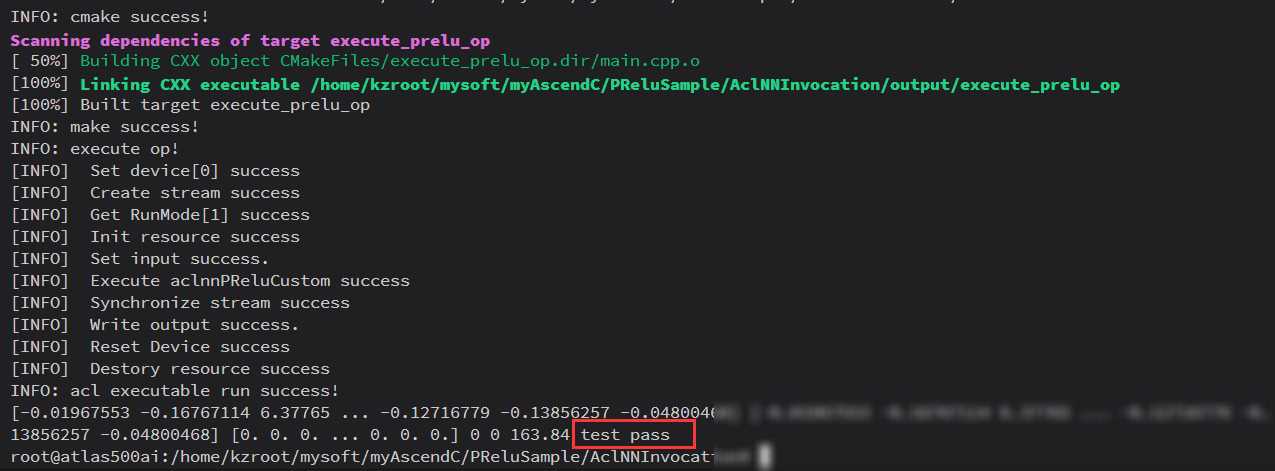

完成算子实现后,我们就可以通过Ascend C提供的编译工具链将算子编译成可在昇腾AI处理器上运行的二进制文件。然后,我们就可以将这个二进制文件部署到我们的深度学习模型中,进行训练和推理了。

在将自定义算子部署到深度学习模型中之前,我们还需要进行一系列的验证和测试,以确保算子的正确性和性能。这些测试可以包括单元测试、集成测试以及性能测试等。

在单元测试中,我们可以编写一些针对PReLU算子的小规模测试用例,检查算子在不同输入下的输出是否符合预期。在集成测试中,我们可以将PReLU算子集成到一个完整的深度学习模型中,检查模型在训练和推理过程中的表现。在性能测试中,我们可以比较使用PReLU算子前后模型的运行速度、资源消耗等指标,以评估算子的性能优劣。

在自定义PReLU算子的过程中,我们也遇到了一些技术挑战。例如,如何确保算子在不同硬件平台上的兼容性?如何优化算子的性能以满足实时性要求?针对这些问题,我们采取了以下解决方案:

跨平台兼容性:通过抽象底层硬件接口,我们实现了算子在不同硬件平台上的统一接口。这样,无论是在华为自家的昇腾AI处理器上,还是在其他兼容的硬件平台上,我们都可以使用相同的算子接口进行开发和部署。

性能优化:我们利用Ascend C提供的性能分析工具对算子进行了深入的剖析,找到了性能瓶颈所在。然后,我们针对这些瓶颈进行了针对性的优化,如利用硬件加速指令、优化内存访问模式等。通过这些优化措施,我们成功地将PReLU算子的性能提升了数倍。

通过本次自定义PReLU算子的实践,我们深刻体会到了深度学习技术中激活函数的重要性以及自定义算子的挑战与乐趣。在未来的工作中,我们将继续探索更多先进的激活函数和算子优化技术,为深度学习领域的发展贡献自己的力量。我们也期待与更多的开发者一起交流学习,共同推动人工智能技术的进步!