Agent推理框架,预测未来,智能规划飞跃!

简单有效的Agent推理框架:PreAct引领智能体规划新篇章

在人工智能(AI)的浩瀚星空中,智能体(Agent)的规划能力一直是我们仰望的璀璨星辰。近年来,随着大语言模型(LLM)的崛起,我们看到了这颗星辰逐渐闪耀出更加耀眼的光芒。传统的ReAct系统虽然在一定程度上利用了LLM的规划能力,但在处理复杂因果关系时仍显得力不从心。在这样的背景下,PreAct推理框架应运而生,它以其独特的方式预测未来,为智能体的规划能力注入了新的活力。

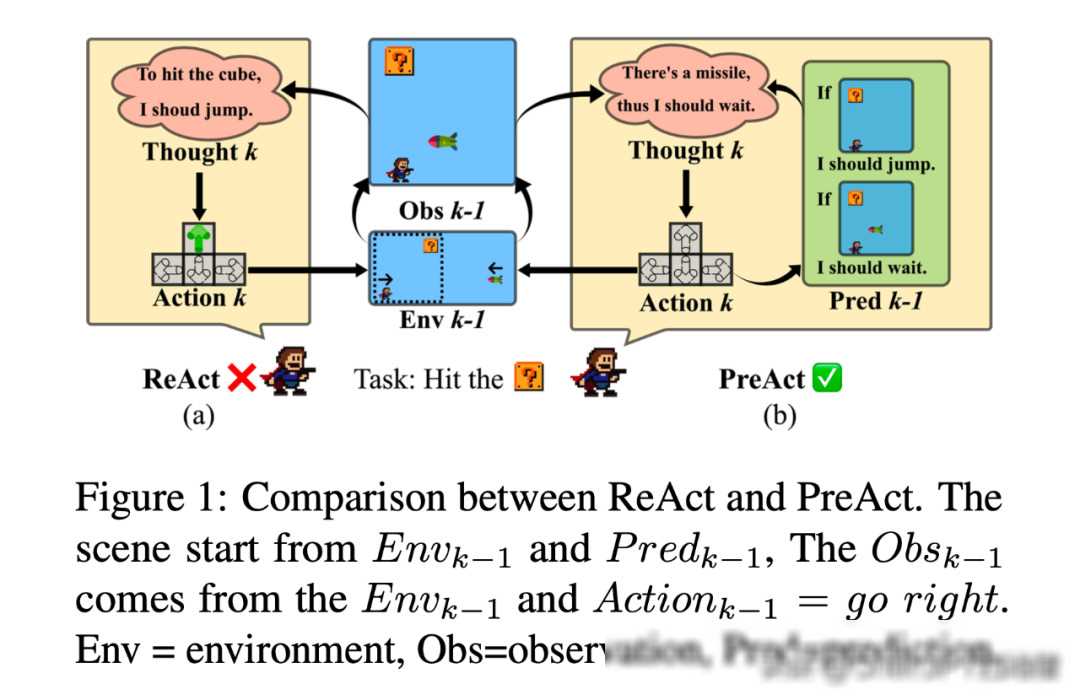

ReAct系统,作为一个面向LLM agent的开创性工作,它结合了思考、行动和观察三个要素,让智能体能够在环境中逐步探索并解决问题。正如我们所知,现实世界的复杂性远非简单的因果链所能涵盖。ReAct系统往往只能生成单一、直接的因果推理路径,这在面对多重选择和复杂环境时显得捉襟见肘。

正是在这样的背景下,PreAct推理框架应运而生。它借鉴了科学研究中的预测与反思机制,将预测、推理和行动融为一体。PreAct不仅要求LLM在每一步中生成对未来观察的预测和相应的应对措施,还鼓励智能体根据预测观察与实际观测之间的差异进行反思或改变其计划方向。这种机制让PreAct在多样性和战略方向性方面展现出了显著的优势。

PreAct的核心在于其独特的预测与反思机制。在每一轮决策中,PreAct都会要求LLM基于当前的环境信息和历史数据,对未来的观察结果进行预测。这种预测不仅涵盖了可能发生的各种情况,还包括了每种情况下智能体应该采取的应对措施。

一旦预测完成,PreAct就会将这些信息传递给智能体,并指导其采取相应的行动。在执行行动后,智能体会获得新的观察结果。此时,PreAct会将实际观察结果与预测结果进行对比,并根据差异大小给出相应的反馈。

如果实际观察结果与预测结果存在较大的差异,PreAct会提示智能体进行反思,并重新考虑其之前的决策过程。这种反思机制不仅有助于智能体发现自身的不足,还能促使其在未来的决策中更加谨慎和全面。

为了验证PreAct的性能和优势,我们在AgentBench的多个数据集上进行了大量的实验。实验结果表明,PreAct在完成复杂任务方面显著优于ReAct方法。具体来说,PreAct在多样性和战略方向性方面展现出了更高的水平,这使得智能体在面对复杂环境时能够更加从容应对。

此外,我们还发现历史预测对LLM规划具有持续的正向影响。随着历史预测数量的增加,智能体的规划能力也在不断提升。这一发现为我们进一步优化PreAct提供了重要的思路。

PreAct推理框架的提出,不仅为我们提供了一种新的智能体规划方法,还为AI领域带来了新的启示。在未来的研究中,我们可以进一步探索PreAct与其他技术的结合,如强化学习、深度学习等,以进一步提升智能体的规划能力。

PreAct也面临着一些挑战。如何准确地预测未来是一个长期存在的难题。尽管我们已经取得了一些进展,但仍有很大的提升空间。如何有效地利用预测信息进行决策也是一个需要深入研究的问题。我们需要设计更加智能的算法和策略,以确保智能体能够充分利用预测信息来指导其行动。

PreAct推理框架的提出,为我们打开了一扇新的窗户,让我们看到了智能体规划能力的无限可能。在这个充满挑战和机遇的时代,我们需要不断探索和创新,以推动AI领域的发展。让我们携手共进,共同迎接AI时代的美好未来!