全模态大模型对齐的深刻探索:技术背后的创新之路

全模态大模型对齐的深刻探索:技术背后的创新之路

亲爱的读者朋友们,今天我们将深入探讨全模态大模型对齐的技术及其在人工智能领域的重要性。你是否曾想过,一个模型如何能够理解和处理图像、音频、视频及文本,从而使得人与智能系统之间的交流更为自然?这背后隐藏着许多创新技术和理论。接下来,让我们逐步揭开这一复杂但迷人的领域。

一、引言

1.1 AIxiv专栏概述

机器之心AIxiv专栏,作为一个专业的学术内容平台,过去数年接收并报道了超过2000篇的学术文章。这些文章涵盖了全球各大高校与企业的顶级实验室,成为了研究人员相互学习和交流的重要桥梁。无论是技术研究,还是学术探讨,AIxiv专栏都致力于促进科研人员之间的深度交流,推动整个人工智能领域的发展。

这里的每一篇文章不仅仅是科研成果的展示,更是对未来可能的应用展示出无限的可能性。如果你在这方面有任何优秀的工作或者想法,都欢迎投稿。你可能在这里找到志同道合的人,一起推动您的研究。

1.2 开源项目背景

北京大学对齐小组是一个专注于人工智能系统的安全交互与价值对齐的团队,成立于近年来人工智能快速发展的背景下。团队由多位才华横溢的年轻学者和研究生组成,指导老师为北京大学人工智能研究院的杨耀东助理教授。核心成员包括吉嘉铭、周嘉懿等,在这一领域积极探索并取得了显著的研究成果。

这个团队的设立不仅是为了在技术层面进行探索,更是希望通过开源的方式让更多人参与到对齐算法的研究和实践中来。他们坚信,只有通过开放和共享,才能更快解决现实问题,推动技术的进步。

二、全模态对齐的必要性与挑战

2.1 人工智能领域的发展趋势

在如今的AI领域中,"有效加速"和"超级对齐"已经成为主要的发展动向。有效加速代表了以OpenAI为代表的大型公司,他们通过快速迭代和大规模数据训练,不断提升模型的能力。而超级对齐则得到了如Llama等众多开源模型的支持,强调的是如何使模型的输出更贴近人类的意图和价值观。

通过加速和对齐,研究者能够更好地满足市场需求,推动商业应用落地。以OpenAI的GPT系列为例,这些模型不仅具有强大的生成能力,还能通过微调实现更精确的任务执行。这种发展趋势预示着,未来的AI可能在多模态理解上取得更大的突破。

2.2 未来全模态模型的重要性

全模态大模型指的是能够处理多种信息类型的人工智能系统。这些模型不仅能理解文本,还能解析图像、音频及视频等多种视觉和听觉信息。大语言模型的模态扩展为我们提供了许多新的思考方向,比如GPT-4o和Chameleon等模型,它们在多模态任务中的表现相较于传统模型有了质的飞跃。

更为重要的是,这种多模态性使得AI能够更加深入地理解人类的表达。例如,在对话中同时使用语言、图像和声音,AI能够综合判断,提供更准确和个性化的反馈。这种能力不仅提升了用户体验,也在医疗、教育等多个领域展现出巨大的应用潜力。

2.3 对齐挑战的复杂性

尽管全模态大模型的潜力巨大,但如何实现这些模型与人类意图的对齐依然是一个极具挑战性的任务。随着模态数量的增加,输入输出的空间分布也趋于复杂,产生了所谓的幻觉现象,即模型可能在判断时产生错误的理解和预测。

在多模态的交互中,不同模态所传递的信息可能会互相矛盾,如何保证系统在处理过程中始终能够输出符合人类期望的结果,是非常关键的。因此,建立一种有效的对齐机制,确保模型能够理解人类多变的意图,是当前研究的重要课题。

三、Align Anything框架的设计与实现

3.1 Align Anything框架的特色

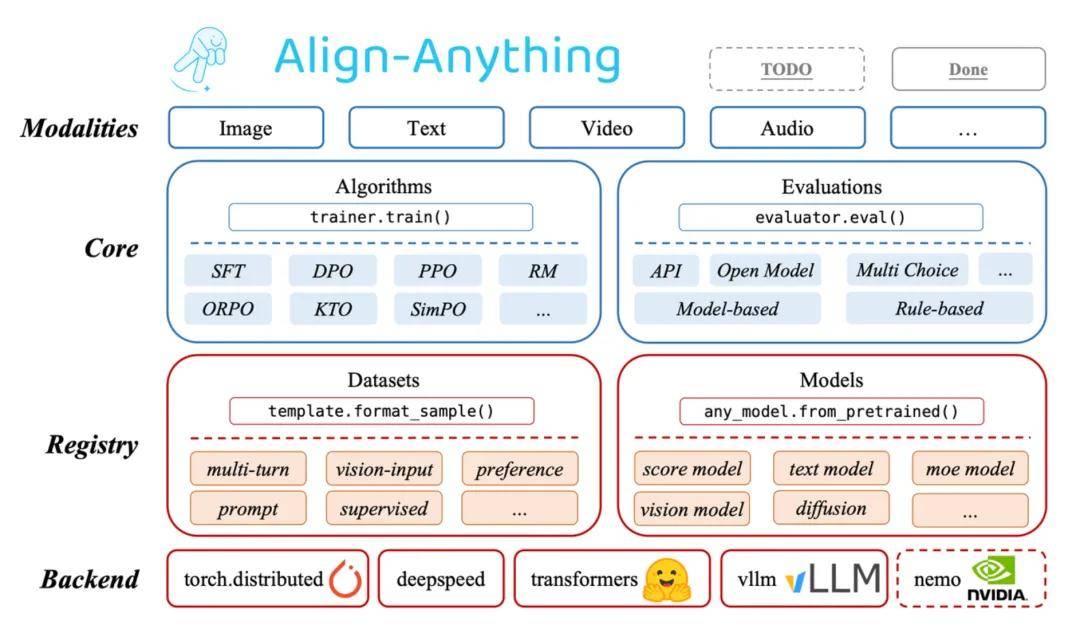

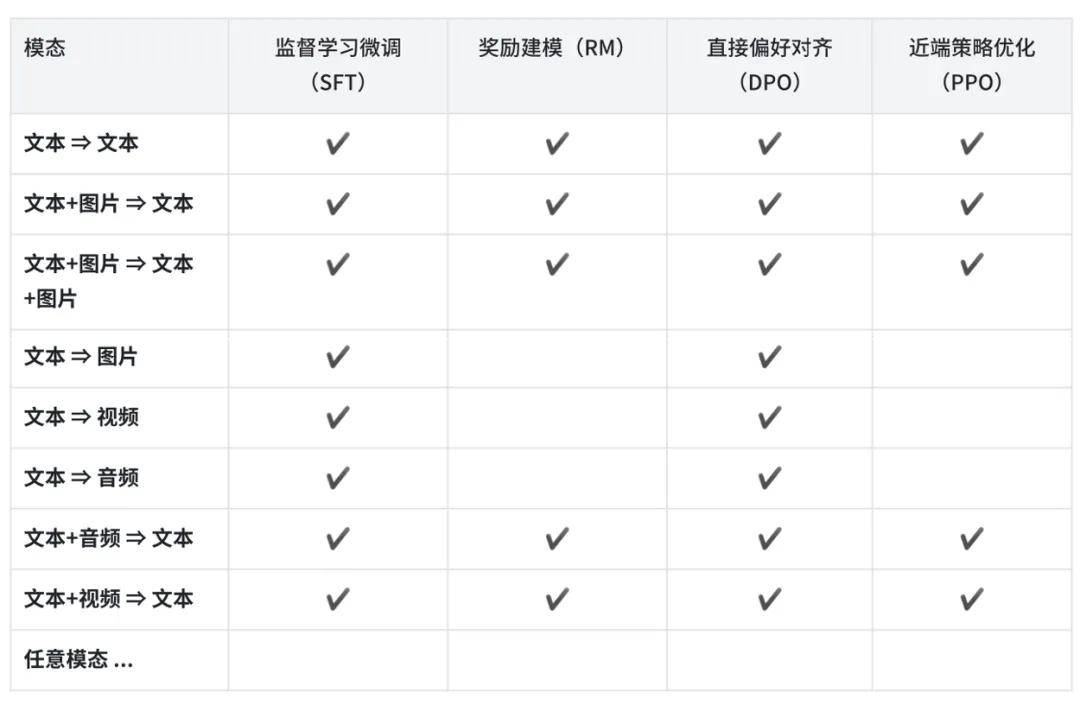

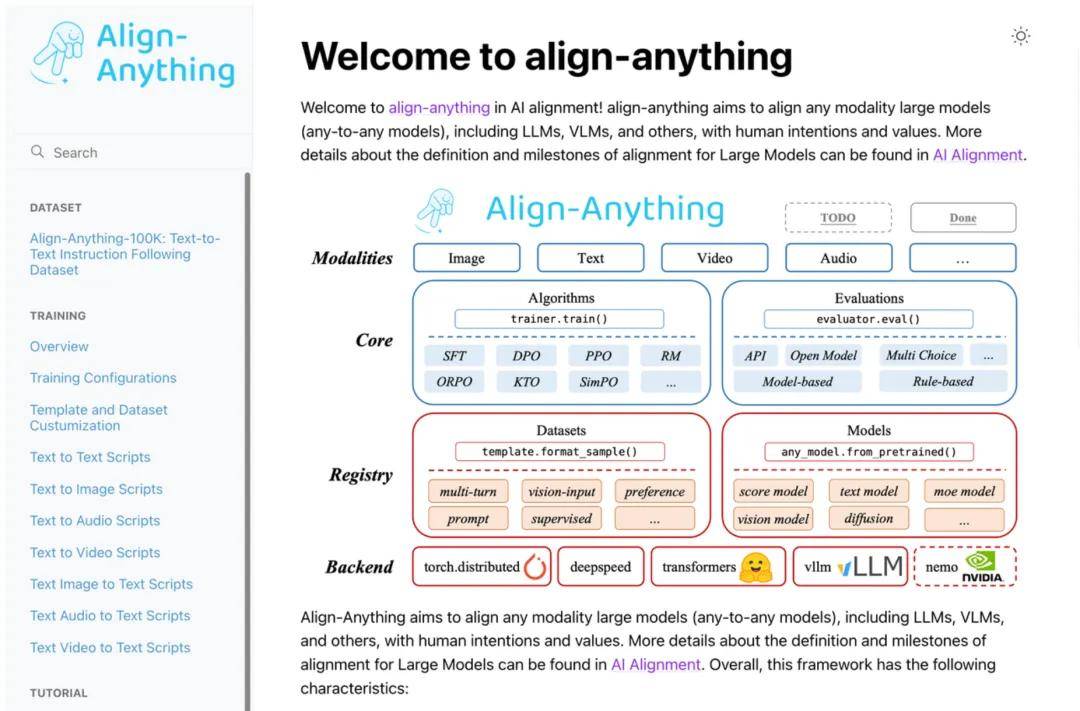

Align Anything框架是由北京大学对齐小组自主研发的,这一框架的最大特点在于其支持多种模态的输入与输出,包括文本、图像、音频及视频等。这一能力使其在开源社区中独树一帜,填补了现有框架仅支持单一或少数模态对齐的空白。

这一框架不仅为研究者提供了统一的解决方案,还能够显著提高模型的训练和评估效率。通过这一框架,研究人员可以实验不同的对齐算法并迅速适应多模态需求。例如,研究者在使用Aligner对某一文本生成模型进行调整时,可以轻松切换到音频或视觉模态进行测试,充分验证模型的多样性。

3.2 数据集的设计与应用

在全模态对齐的过程中,数据质量至关重要。Align Anything框架采用的Align-Anything人类偏好数据集,旨在提供高质量的全模态训练数据。这一数据集涵盖了指令跟随、情感认知和内容生成等多个复杂任务,通过涉及多种模态的数据,确保了训练的全面性和准确性。

该数据集提供了详尽的人类偏好注释,包括对模型输出的批评和改进建议。此举不仅能够增强模型的多模态理解能力,还能促进跨模态的全面评估和改进。从数据采集、处理到标注的每一个环节,都经过严格把关,以保障最终模型的优良性能。

3.3 对齐框架的功能模块

Align Anything框架的设计理念强调模块化,这意味着用户可以根据自己的需求自由选择和组合相应功能。这一设计使得框架对不同算法类型进行抽象化,并提供了精心设计的API,方便用户进行定制化开发。例如,研究者利用这一框架可以添加新的对齐算法,而无需从头开始重做大规模的框架调整。

扩展性是框架另一大亮点,支持用户快速注册新模型或数据集。通过简单的几行代码,用户即可在框架中实现新的模型或数据集的集成。这种灵活性极大地提升了研究效率,使得模型的迭代更新变得更加迅速。

四、基于Align Anything框架的实验与结果

4.1 Beaver-Vision-11B模型的构建与性能

在Align Anything框架的支持下,北大对齐小组基于Llama-3.2-Vision的预训练版本进行了后训练,成功构建了Beaver-Vision-11B模型。这一新模型在多个评测标准上超越了Meta发布的Llama-3.2-11B-Vision-Instruct,表现出更加优越的对齐能力与指令跟随性。

这一模型的成功构建,依赖于大量的训练数据和多模态反馈。具体实验显示,该模型在复杂的多模态任务中,不但能够准确地理解图像内容,还能结合文本信息进行推理,最终形成完整的回答。例如在图像与文本结合的问答任务中,Beaver-Vision-11B能够迅速识别图中元素,提供详尽、准确的回答,其表现优于许多同类模型。

4.2 指令跟随与对齐能力的提升

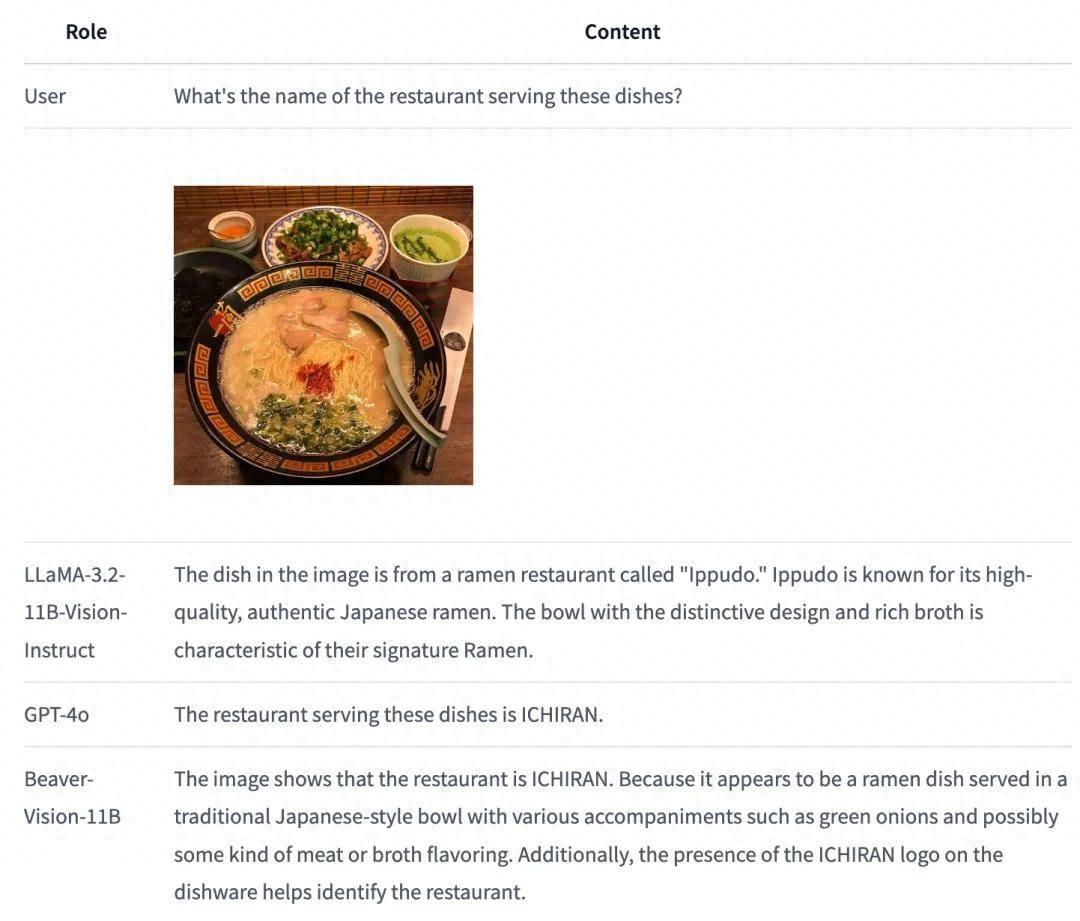

在对Llama-3.2-11B-Vision-Instruct进行指令跟随行为的评估时,发现该模型在处理任务时部分问题的表现并不如意,比如在问到“图中的拉面来自于哪家餐厅?”时,模型给出的答案未能明确识别出餐具中的“意兰”字样,而是错误解读为其他餐厅。

而Beaver-Vision-11B能够准确识别文本,并提供合理的推理过程。其不仅识别出“一兰”字样,更直接给出与之相关的餐厅信息及背景,证明其在对齐算法上的优势。这一实验不仅突显了Beaver-Vision-11B的强大能力,更为今后相关模型的开发提供了宝贵的参考数据。

4.3 评测框架与未来研究方向

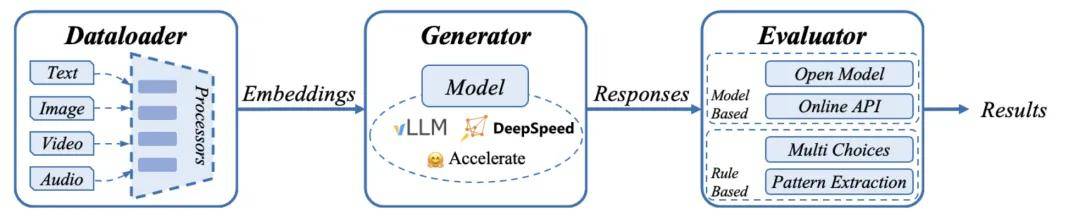

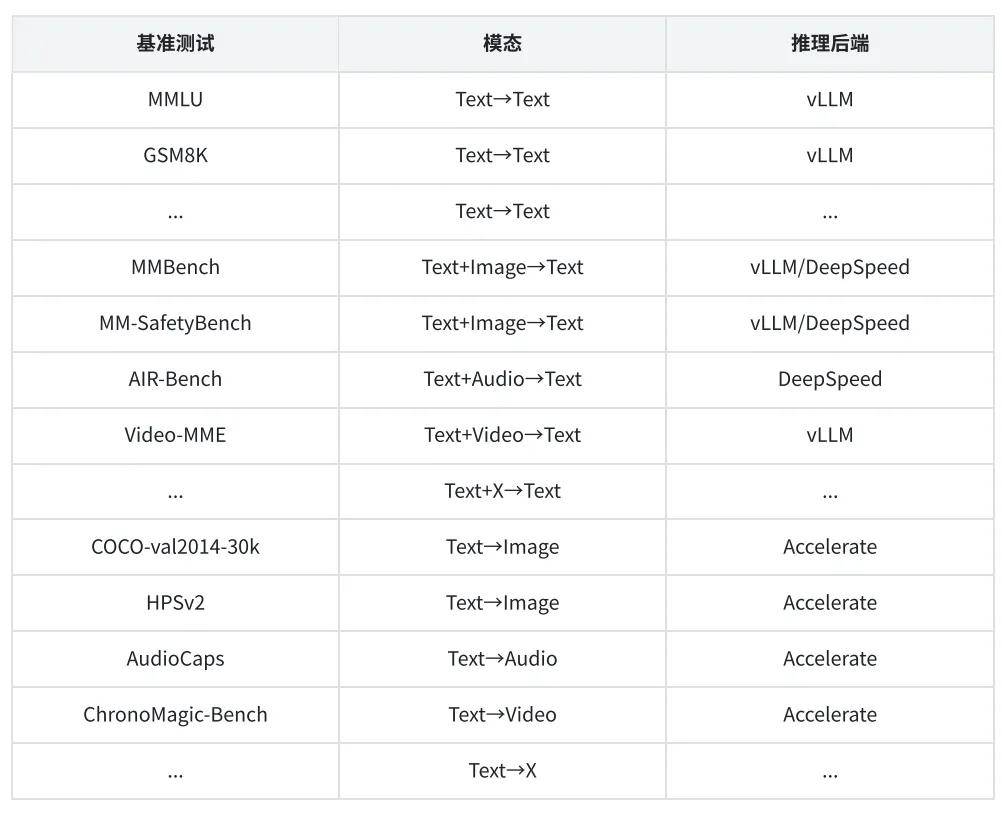

Align Anything框架内置了多种评测方案,能够适配超过30个常用的基准测试。这些测试涵盖了不同的多模态评测需求,如文本到文本、图像到文本等,确保了对模型性能的全面评估。

在未来的研究方向上,将继续扩展这一评测框架的能力,以实现更广泛的模态支持。考虑到多种推理后端的适配,Align Anything评测框架通过解耦合的方法,提升了评测过程的灵活性和效率。这一特征能够使得同一个框架支持不同类型的模型,从而在多模态理解与生成的广泛领域中保持高效性与适应性。

五、对齐算法的广泛应用

5.1 从全模态学习的系统范式

随着Align Anything框架的推行,团队提出了从语言反馈中学习的全新范式。这种方法通过丰富的反馈信息,帮助模型更精准地进行全模态对齐。具体来说,该方法包括模型建模、生成修正、自我提升及强化学习微调等四大步骤,确保模型能够在多模态场景中表现出色。

在文本到图像的生成过程中,模型首先生成一个粗略的图像,然后利用评论模型对其进行评估和反馈,再通过反馈修正输出,有效提升图像生成的准确性。此方法不仅提升了对齐能力,也增强了模型的自我学习能力,使其在实际应用中具备更强的多样性和适应性。

5.2 实验中的模型与数据

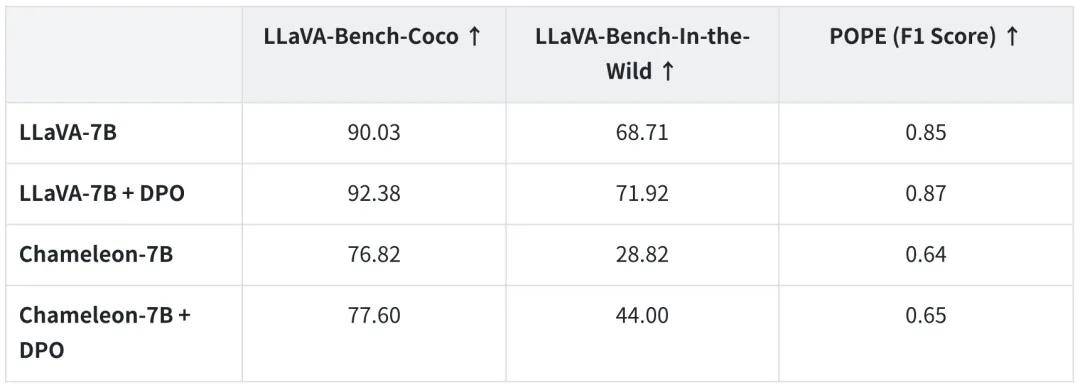

北大对齐小组在对齐算法的实验中,实施了多种模态的结合测试,包括文本、音频、视觉等。对齐算法能够显著提升模型的指令跟随能力,并在多个开源榜单上取得优越成绩。这些实验包括经典视觉语言模型如LLaVA以及最新的Meta Chameleon系列模型,均对Align Anything的实施效果给予了积极评价。

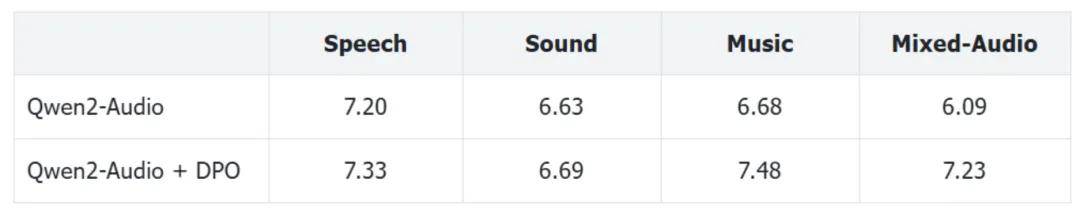

在音频与文本混合模态的实验中,Qwen2-Audio模型的表现,依赖于DPO算法在后训练阶段的实施,使得该模型在AIR Bench等评测中取得显著提升。这再次证明了对齐算法在多模态领域的不可或缺性,未来还需更广泛地挖掘其潜力。

六、综合示例:指令跟随能力的提升

通过Align Anything框架构建的全面研究与实验,展示了全模态对齐在多模态任务处理中的巨大优势。Align-Anything数据集作为项目的核心,也为后续的研究提供了坚实基础。数据集中的反馈机制使得研究人员能够从人类偏好中提取有效信息,从而实现更高精度的模型调优。

通过与市场需求的结合,团队发现在模态复杂性不断增加的情况下,传统的单一模态数据无法满足实际需求。而Align-Anything数据集则通过多模态的结合,引入了更为丰富的反馈数据,从而提升了模型在实际应用中的适应能力。这一案例不仅表明了全模态对齐的必要性,同时也为后续的研究指明了方向。

通过深入探讨全模态大模型对齐的创新与实施,让我们对这一新兴领域有了更为清晰的理解。希望对您在技术探索与实践中的应用提供了有价值的参考与帮助。欢迎大家在下方留言讨论,分享您的看法!