北大林宙辰团队:革新神经网络架构,实现万有逼近!

北京大学林宙辰团队突破神经网络架构设计:引领深度学习新篇章

随着人工智能技术的飞速发展,深度学习已成为推动科技进步的重要引擎。在深度学习领域,神经网络架构的设计对于模型的性能至关重要。一个好的神经网络架构能够融入问题的先验知识,稳定网络训练,提高计算效率。如何设计具有万有逼近性质的神经网络架构,一直是业界和学术界关注的焦点。近日,北京大学林宙辰教授团队在神经网络架构设计方面取得了重要突破,他们提出了一种全新的基于优化算法的神经网络架构设计方法,这一成果不仅为深度学习领域带来了新的思考,也为未来的研究指明了方向。

一、神经网络架构设计的挑战与现状

神经网络架构是深度学习模型的核心组成部分,它决定了模型如何对输入数据进行处理和转换。在实践中,网络架构可以显著影响学习效率。一个好的神经网络架构能够充分利用数据的特征,提高模型的泛化能力。设计一个好的神经网络架构并非易事。传统的神经网络架构设计方法主要包括人工设计、神经网络架构搜索(NAS)和基于优化的网络设计方法。

人工设计的网络架构,如ResNet、DenseNet等,虽然在许多任务上取得了优异的性能,但它们往往需要经验丰富的专家根据特定问题的特点进行精心设计。神经网络架构搜索则通过搜索或强化学习的方式在搜索空间中寻找最佳网络结构,这种方法虽然能够自动化网络架构的设计过程,但计算成本较高,且搜索空间巨大,难以保证找到全局最优解。基于优化的设计方法则从一个具有显式表示的目标函数出发,采用特定的优化算法进行求解,再将优化迭代格式映射为神经网络架构。这种方法受限于目标函数的显式表达式,可设计得到的网络结构有限。

二、林宙辰团队的创新突破

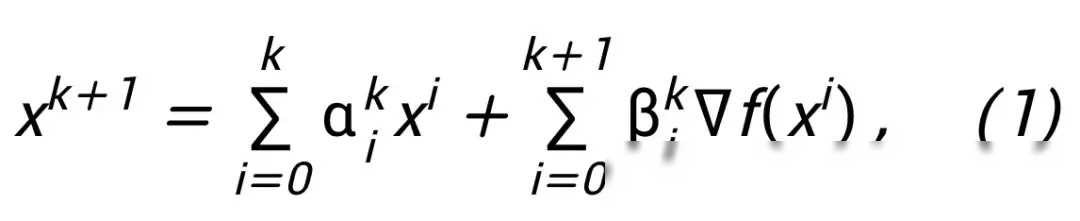

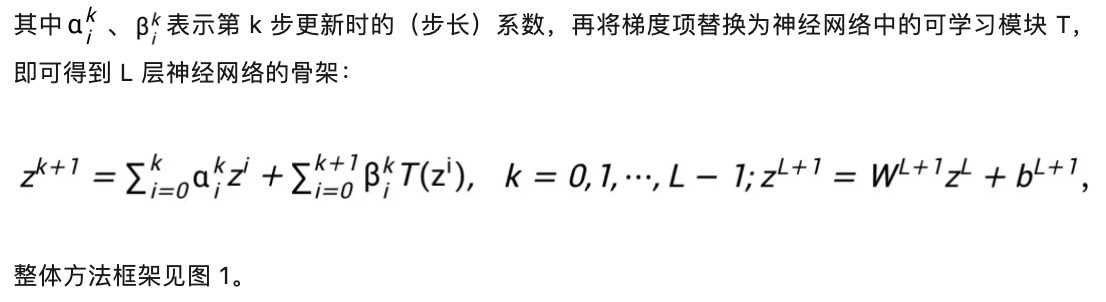

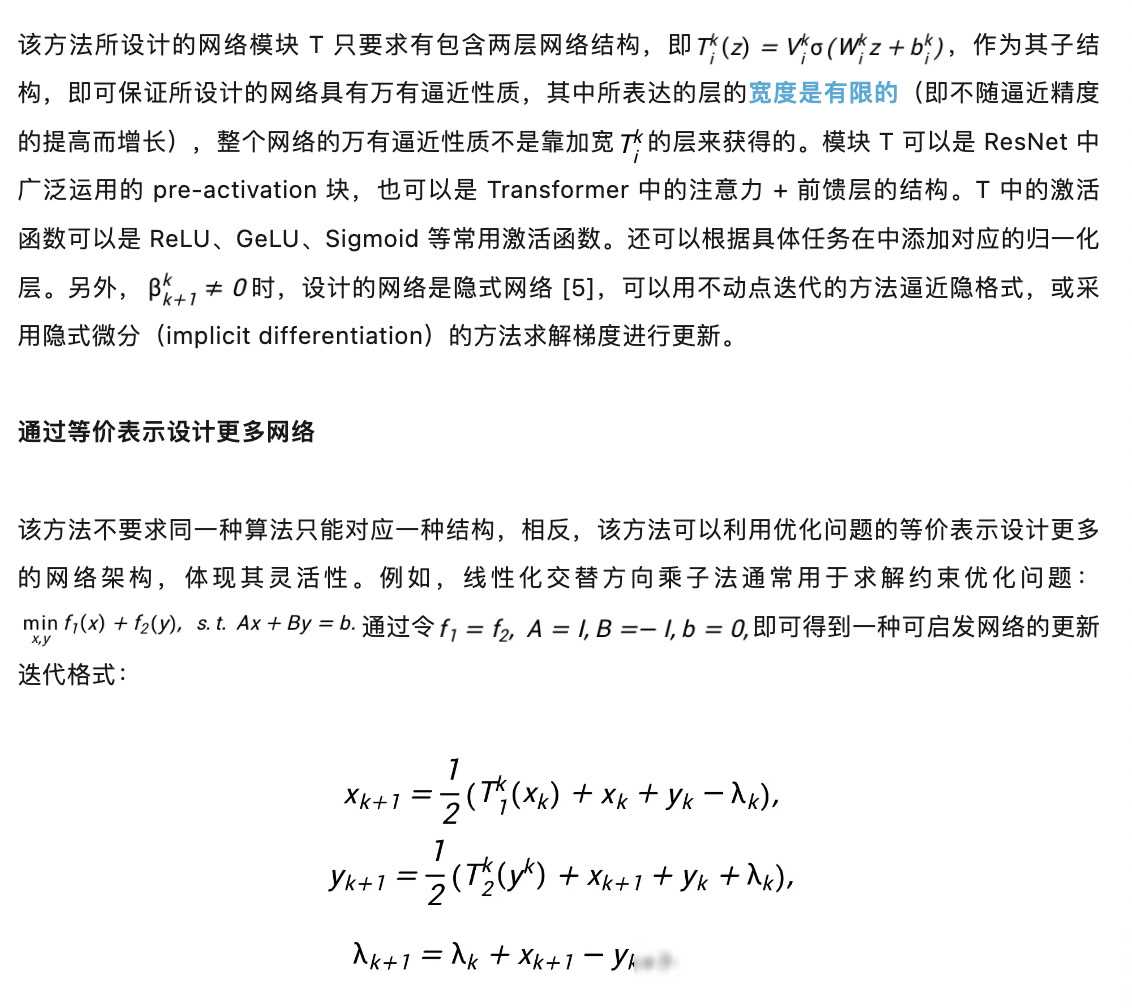

针对现有神经网络架构设计方法的局限性,林宙辰教授团队提出了一种全新的基于优化算法的神经网络架构设计方法。该方法将基于梯度的一阶优化算法的梯度项映射为具有一定性质的神经网络模块,再根据实际应用问题对模块结构进行调整,就可以系统性地设计具有万有逼近性质的神经网络架构。这一方法不仅解决了传统方法中存在的局限性,而且能够设计出具有更强泛化能力和更高计算效率的神经网络架构。

具体来说,林宙辰团队的方法从一阶优化算法的更新格式出发,将梯度或邻近点算法写成更新格式,并将这些更新格式映射为神经网络模块。这些模块可以根据实际应用问题的特点进行灵活调整,从而设计出符合问题需求的神经网络架构。通过这种方法,林宙辰团队成功地设计出了一系列具有万有逼近性质的神经网络架构,并在多个数据集上取得了优异的性能。

三、实验验证与结果分析

为了验证所提出方法的有效性,林宙辰团队在多个标准数据集上进行了实验验证。他们首先使用所提出的方法设计了多个神经网络架构,并将这些架构与现有的经典网络架构进行了对比。实验结果表明,所设计的神经网络架构在多个数据集上均取得了超越基线的性能。

此外,林宙辰团队还通过理论分析证明了所设计网络架构的万有逼近性质。他们利用神经网络微分方程(NODE)的逼近性质,证明了在模块满足一定条件以及优化算法稳定、收敛的条件下,任意一阶优化算法启发的神经网络在高维连续函数空间具有万有逼近性质。这一理论结果不仅为所提出方法的有效性提供了理论支持,也为未来的研究提供了新的思路。

四、技术意义与未来展望

林宙辰团队所提出的基于优化算法的神经网络架构设计方法具有重要意义。该方法突破了现有方法的局限性,能够设计出具有更强泛化能力和更高计算效率的神经网络架构。该方法将优化算法与神经网络架构设计相结合,为深度学习领域带来了新的思考。该方法为未来的研究提供了新的方向,可以进一步探索不同优化算法在神经网络架构设计中的应用。

展望未来,随着深度学习技术的不断发展,神经网络架构设计将继续成为研究的热点。林宙辰团队所提出的基于优化算法的神经网络架构设计方法为我们提供了新的思路和方法。相信在未来,这一领域将会出现更多具有创新性和实用性的成果,为人工智能技术的发展贡献更多智慧和力量。