你知道吗?视觉定位技术让图像理解变得更聪明!

你知道吗?视觉定位技术让图像理解变得更聪明!

亲爱的读者朋友们,今天我们将深入探讨一个在计算机视觉领域备受瞩目的技术——视觉定位。这一技术的关键在于如何通过自然语言文本精确定位图像中的目标物体。想要了解这些技术背后的奥秘吗?接下来,我们就来揭开它的面纱。

一、视觉定位的定义

视觉定位(Visual Grounding)是计算机视觉与自然语言处理两大领域的交叉点,旨在通过自然语言描述,精确定位图像中对应的目标物体。这项技术对提升计算机理解能力具有重要意义,尤其在视觉问答、图像描述等多模态应用中尤为关键。

我们生活中有许多场景都在应用视觉定位技术,比如在智能家居中通过语音助手来控制家电,或是在社交媒体中通过文本搜索找到相关图片。视觉定位的精准度直接影响这些应用的用户体验与功能实现。因此,深入理解视觉定位的现状和挑战,对于相关技术的研究与发展至关重要。

二、视觉定位的挑战

在视觉定位技术的实际应用中,面临着一些挑战,特别是稀疏监督信号的问题。传统的目标检测任务依赖大量的标注数据,而视觉定位每对文本和图像仅提供一个边界框标签,造成指导信息的稀缺。这与目标检测的重标注和多样化数据的丰富性形成了鲜明的对比。

这种稀疏标签的限制使得很多视觉定位模型的泛化能力和效果受到影响。例如,研究发现,在一些复杂场景中,由于缺乏额外的上下文信息,模型往往无法准确地理解伴随文本所指向的具体目标。而当我们考虑将框注释转化为分割掩膜,就能提供更多的像素级监督,实现更高精度的目标定位。

视觉定位与目标检测的不同之处在于,它不仅仅是识别物体,并且要求建立目标与文本描述之间的一种联系。这种关联的建立需要模型具备处理自然语言的能力,因此,对模型的训练提出更高的要求。对这些挑战的深入分析,将帮助我们更好地制定解决方案,提高视觉定位的准确性和可靠性。

三、SegVG方法介绍

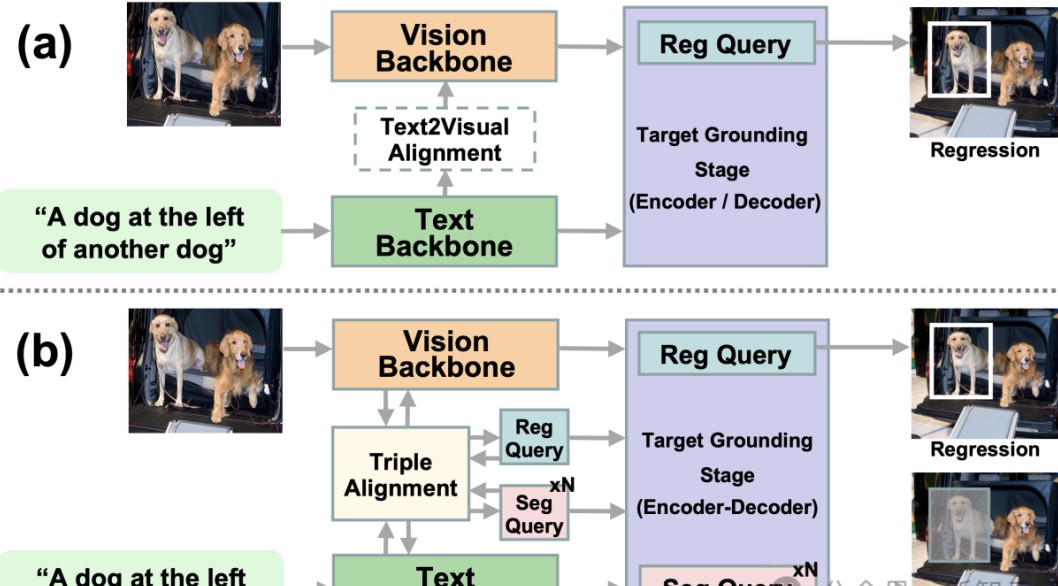

为了更好地解决上述挑战,研究者们提出了一种名为SegVG的新方法。SegVG的目标是将边界框级的注释转化为分割信号,从而提供更为丰富的监督信号。这种技术不仅能够提升模型对边界框的理解,还能在后续的像素级别上实现更精细的目标定位。

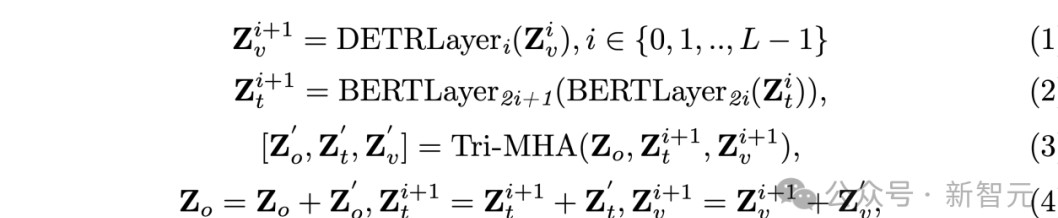

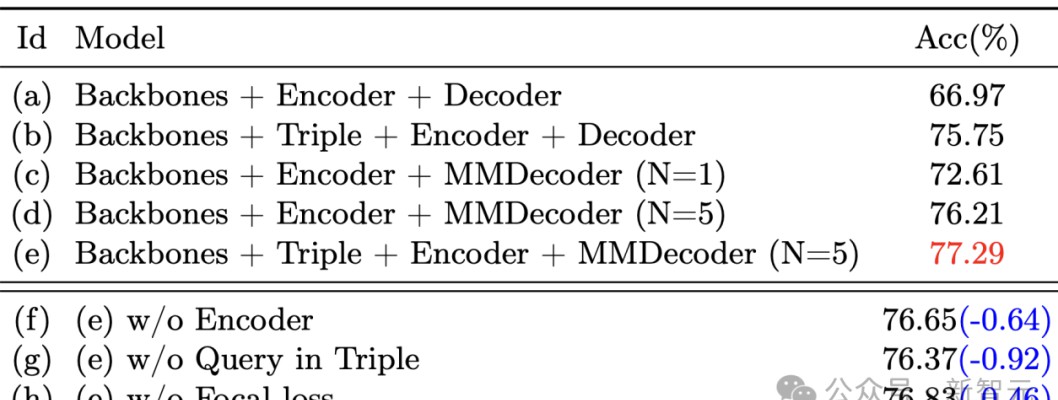

SegVG方法的核心在于采用多层多任务编码器-解码器架构,这种结构增强了模型的多模态学习能力,能够同时处理文本和图像的特征。在具体实现中,SegVG利用了三重对齐模块,通过这种特定结构,确保查询、文本与视觉特征在同一特征空间中对齐,从而改善目标检测的效果。

在实际应用中,SegVG的表现优于传统方法。研究表明,该方法在提高边界框注释利用效率的同时,能够有效降低特征域的差异。因此,通过这项创新的技术,SegVG为视觉定位任务提供了一条新的思路,为后续研究奠定了基础。

四、SegVG的关键组件

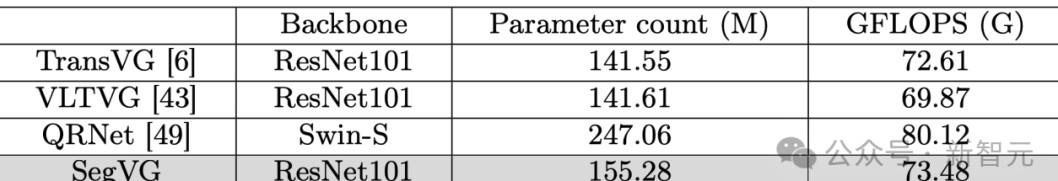

视觉骨干网络和文本骨干网络是SegVG方法中两个核心组件。视觉骨干网络负责从输入的图像中提取特征,它通常使用经过目标检测任务在标准数据集如MSCOCO上预训练的网络架构,例如ResNet和DETR(Detection Transformer)模型。这些预训练模型对提升视觉特征提取的稳定性和效率具有积极作用。

文本骨干网络则利用BERT(Bidirectional Encoder Representations from Transformers)将输入文本转换为语言Token,通过适当的嵌入层处理,为后续的语言理解提供强有力的支持。使用[CLS]和[SEP]标记的设计能够帮助文本信息更好地融入到后续的处理流程中,确保不同类型特征的有效融合。

三重对齐模块的引入是SegVG的一个重要创新。该模块通过三角形特征采样,利用注意力机制确保视觉特征、文本特征和查询特征之间的一致性。这意味着,无论是在输入还是输出中,不同特征的融合和对齐都是在同一空间中进行的,这对后续的目标定位任务是非常关键的。

在训练过程中,SegVG通过迭代优化的方式,不断调整各个组件之间的权重,从而提升各个特征的表示能力。这种设计不仅提高了模型处理复杂查询的能力,也极大地增强了最终目标定位的准确性。

五、模型训练与损失函数

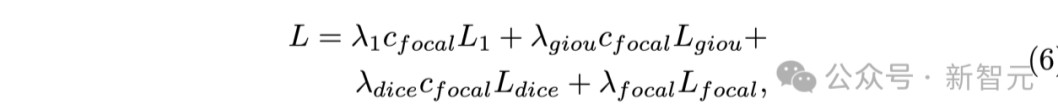

在深入研究模型训练的过程中,SegVG采用了一系列损失函数来驱动模型的学习过程。常用的损失函数包括L1损失、GIoU损失、Focal损失和Dice损失。这些损失函数各自能在不同阶段提供有效的反馈,帮助模型更好地优化其目标定位能力。

L1损失关注的是模型预测和真实值之间的绝对误差,而GIoU损失则提供了更好的位置质量评估,通过计算预测框与真实框之间的重叠率来增强定位能力。Focal损失的引入尤为重要,它能够强调那些难以训练的样本,譬如背景信息复杂的场景,通过加大这些样本在训练中的权重,从而提升模型对困难实例的学习能力。

对这些损失函数的综合利用,确保了模型在回归与分割任务中均能得到强化的训练反馈。这为SegVG在实际应用中展示出色的效果提供了有力支持。

训练过程的每个环节都需要注意超参数的设置和调整,例如学习率和权重衰减参数等。这些超参数的选择会直接影响模型的收敛速度和最终效果,因此,应该根据具体问题进行调优。在训练初期,可以通过较大的学习率加速收敛,而在接近收敛时逐渐降低学习率以进一步精细调整。

六、实验设置与评估

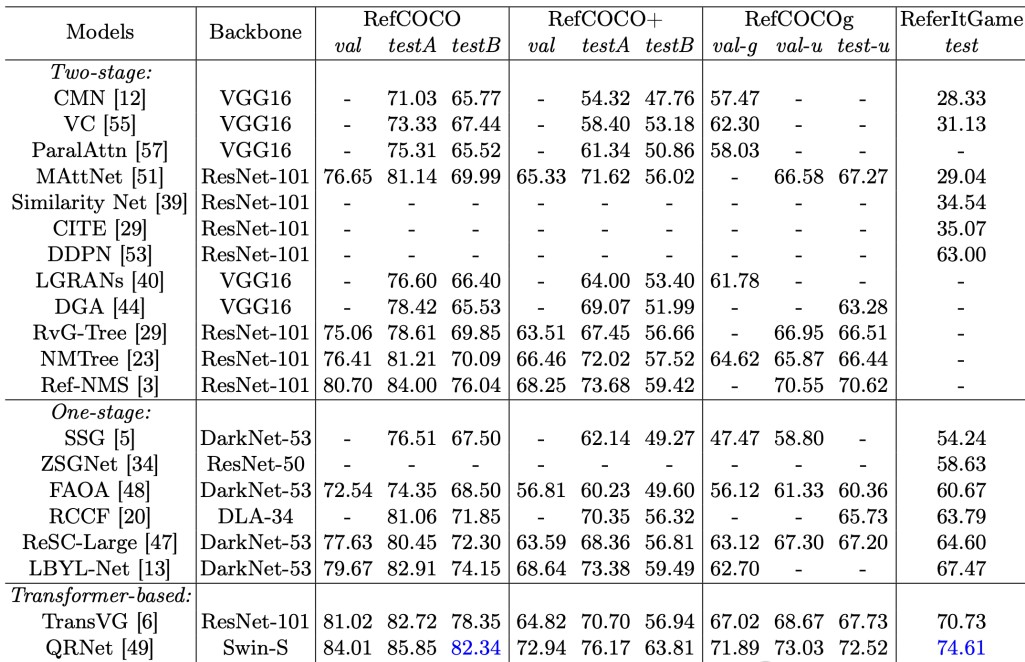

在评估SegVG模型的有效性时,研究者采用了多个标准数据集,涵盖了RefCOCO、RefCOCO+、RefCOCOg-g、RefCOCOg-umd及Refer It Game等。为了确保评估的全面性和准确性,这些数据集的选择是经过深思熟虑的,代表了不同的视觉定位任务挑战。

在评估过程中,主要使用的指标包括交并比(IoU)和前1准确率。IoU是用来衡量预测框与真实框之间重叠程度的重要指标,而前1准确率则反映了模型在给定文本条件下成功定位目标的能力。

针对输入数据,研究者特意进行了配置,以640x640的图像大小进行训练,同时设置最大文本长度为40。这种配置不仅有助于保持训练过程中的一致性,还有助于模型在实际应用中的适应性。

SegVG模型在所有基准数据集上的表现均优于已有的最先进模型。例如,在RefCOCO+数据集中,其在不同子集上的准确率分别实现了2.99%、3.7%和2.42%的显著提升。这一结果不仅验证了SegVG方法的有效性,也为后续研究提供了有价值的参考。

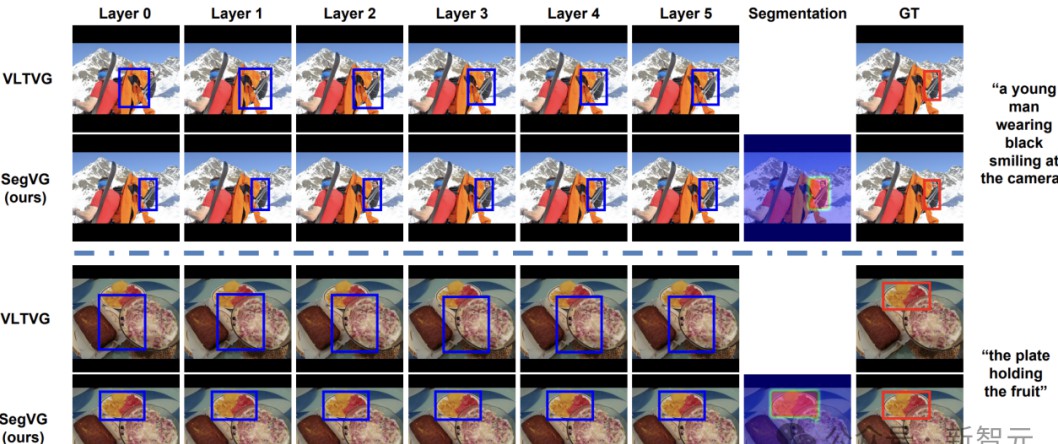

七、案例展示

在多任务优化的实际应用中,SegVG展示了其高效性。例如,在处理复杂背景下的目标定位时,通过模型的训练和优化,成功地定位了多种物体。这不仅体现了SegVG在像素级分割与边界框回归方面的能力,还显示了其对复杂查询的优秀理解能力。

具体案例显示,在一个城市街道场景中,SegVG能够准确识别并定位行人、车辆和交通标志等多个目标,这得益于模型的精细化设计与优化。在目标探测中,SegVG在初步解码阶段便能识别目标位置,远超传统模型在处理复杂问题时的表现。

通过这样的案例分析,不仅让我们看到了SegVG技术的实际应用价值,还增强了这一方法的可行性引导了未来在视觉定位领域的发展方向。同样也为其他领域的多模态理解提供了借鉴和启示。

欢迎大家在下方留言讨论,分享您的看法!