DenseNet揭秘:密集连接卷积网络新纪元!

探索DenseNet:密集连接卷积网络的奥秘

在深度学习的广阔天地中,卷积神经网络(CNN)早已成为图像识别、自然语言处理等领域的明星技术。随着数据量的不断增长和模型复杂度的日益提高,传统的CNN架构逐渐面临一些挑战,如梯度消失、参数冗余等问题。在这样的背景下,DenseNet——一种被称为“密集连接卷积网络”的深度学习架构,以其独特的密集连接设计,为解决这些问题提供了新的思路。

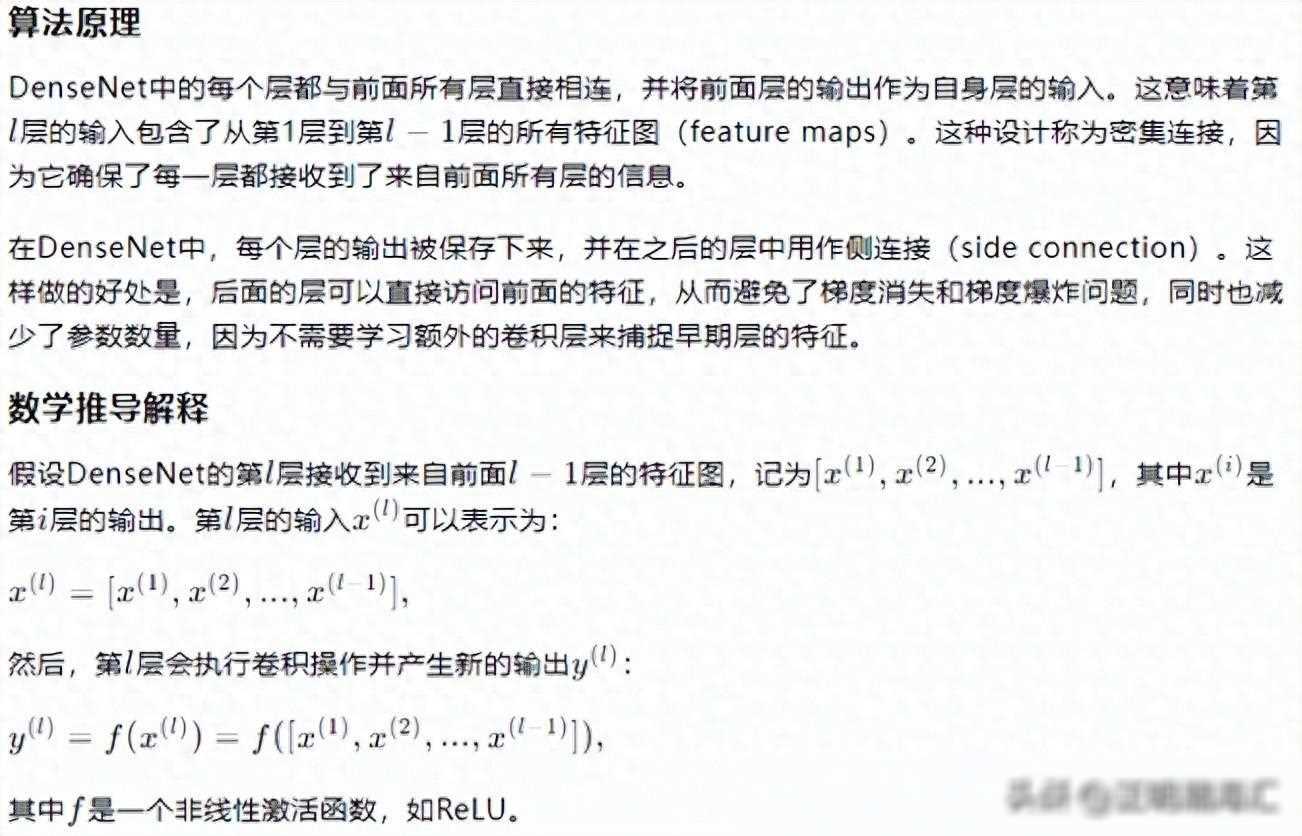

DenseNet的诞生可以追溯到2016年,由Gao Huang、Zhuang Liu、Kilian Q. Weinberger和Laurens van der Maaten等研究者共同提出。这一架构的核心思想在于通过密集连接(Dense Connection)或称为特征重用(Feature Reuse),使得每一层的输出都直接连接到后面所有层的输入,从而形成一个紧密的、逐层连接的网络结构。

这种设计的好处在于,它不仅大大减少了网络中的梯度消失问题,提高了信息在网络中的流动效率,还通过特征重用有效减少了参数数量,降低了过拟合的风险。因此,DenseNet在图像分类、目标检测等任务中取得了显著的性能提升,成为深度学习领域的一颗璀璨新星。

DenseNet的核心特点在于其密集连接的设计。具体来说,它采用了以下两种关键技术:

密集块(DenseBlock):DenseNet将网络划分为多个密集块,每个密集块内部包含多个卷积层。与传统的CNN不同,DenseBlock中的每一层都将其输出作为后面所有层的输入,从而实现了特征的逐层传递和重用。这种设计使得网络中的每一层都能够充分利用前面所有层的特征信息,提高了信息的利用率。

过渡层(Transition Layer):为了降低模型的复杂度并减少计算量,DenseNet在密集块之间引入了过渡层。过渡层主要包括一个卷积层和一个池化层,用于对密集块的输出进行降维和降采样。通过这种方式,DenseNet可以在保持特征重用的有效地控制模型的复杂度和计算成本。

在实际应用中,DenseNet的实现通常基于深度学习框架如PyTorch或TensorFlow。下面我们以PyTorch为例,简要介绍DenseNet的实现过程:

我们需要定义一个初始卷积层,用于对输入图像进行初步的特征提取。然后,我们按照一定的规则堆叠多个密集块和过渡层,构建出完整的DenseNet网络结构。在每个密集块中,我们可以根据任务需求调整卷积层的数量和参数设置;在过渡层中,我们可以选择不同的池化方式和降采样比例来控制模型的复杂度。

在训练过程中,我们通常采用反向传播算法和梯度下降优化器来更新网络参数。由于DenseNet的密集连接设计使得梯度在网络中传播得更加顺畅,因此它往往能够在较少的迭代次数内达到较高的性能。

在图像分类任务中,DenseNet表现出了出色的性能。例如,在ImageNet数据集上,DenseNet-121和DenseNet-169等模型在保持较低计算成本的取得了与ResNet-101相当甚至更高的分类准确率。这表明DenseNet在处理大规模图像数据时具有较强的泛化能力和鲁棒性。

除了图像分类任务外,DenseNet还可以应用于目标检测、图像分割等其他视觉任务。在这些任务中,DenseNet可以通过修改网络结构和损失函数等方式进行适应和优化。此外,DenseNet的思想还可以扩展到其他类型的深度学习模型中,如循环神经网络(RNN)和生成对抗网络(GAN)等,为这些模型的设计和优化提供了新的思路。

尽管DenseNet已经在多个任务中取得了显著的性能提升,但其仍然面临一些挑战和未来发展方向:

模型压缩与加速:随着深度学习模型的不断增大和复杂化,如何在保持性能的同时降低模型的计算成本和存储需求成为了一个重要的问题。未来的研究可以探索如何通过剪枝、量化、知识蒸馏等技术对DenseNet进行压缩和加速,以满足实际应用中的需求。

动态网络结构:传统的DenseNet采用了固定的网络结构,无法根据输入数据的特点自适应地调整网络参数和复杂度。未来的研究可以探索如何设计具有动态网络结构的DenseNet,使其能够根据不同的任务和数据自适应地调整网络结构和参数设置。

跨领域应用:目前DenseNet主要应用于计算机视觉领域,但在自然语言处理、语音识别等其他领域的应用还相对较少。未来的研究可以探索如何将DenseNet的思想和技术应用于这些领域,以推动深度学习技术的跨领域发展。

总之,DenseNet作为一种先进的深度学习架构,在图像分类、目标检测等任务中表现出了出色的性能。未来随着技术的不断发展和创新,DenseNet有望在更多领域发挥重要作用,为人工智能的发展贡献更多的智慧和力量。