一文看懂递归神经网络(RNN):未来科技的关键解码器,你了解多少?

一文看懂递归神经网络(RNN):未来科技的关键解码器,你了解多少?

亲爱的读者朋友们,随着人工智能的迅猛发展,我们生活中无处不在的数据处理需求也不断提升。今天,我们将深入探讨一种强大的工具——递归神经网络(RNN),它在自然语言处理、语音识别和时间序列分析等领域发挥着巨大的作用。通过这篇文章,希望能够帮助你全面了解RNN的基本构架、工作原理以及在实际应用中所面临的挑战和解决方案。

一、顺序数据的重要性

顺序数据,顾名思义,指的是按照特定顺序排列的数据类型,例如时间序列、文本序列等。在现代科技中,它们无处不在:社交媒体上的文本评论、金融市场的历史价格走势、音频信号的时间变化等都属于此类数据。顺序数据的重要性在于,很多时候,数据的价值不只是孤立地看待某一个时刻,而是从整体的时间线来理解其变化和关联。

尽管顺序数据的应用日益广泛,但它也带来了许多挑战。我们该如何有效捕捉这种数据中潜在的上下文信息?传统的神经网络,虽然在处理静态数据上表现优异,但对于需要时间依赖性的任务,却面临着巨大挑战。它们往往只能关注当前输入的特征,而无法同时考虑到过去的数据和潜在的长远关联。

二、递归神经网络(RNN)的基础

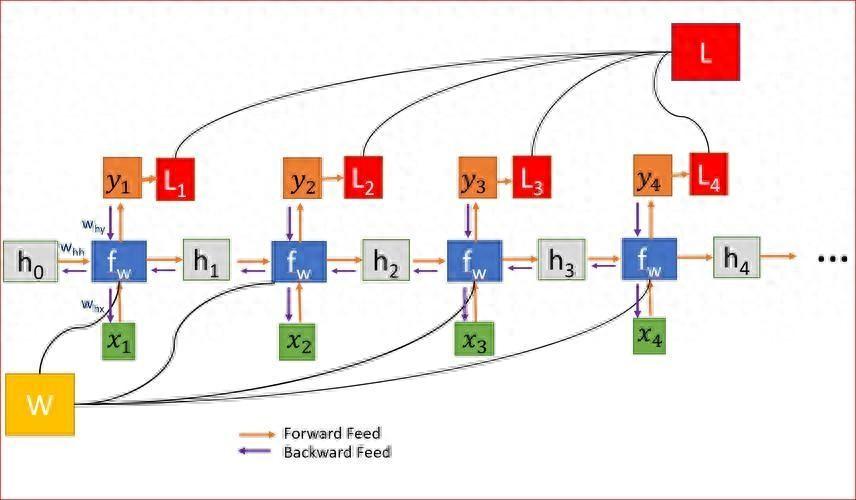

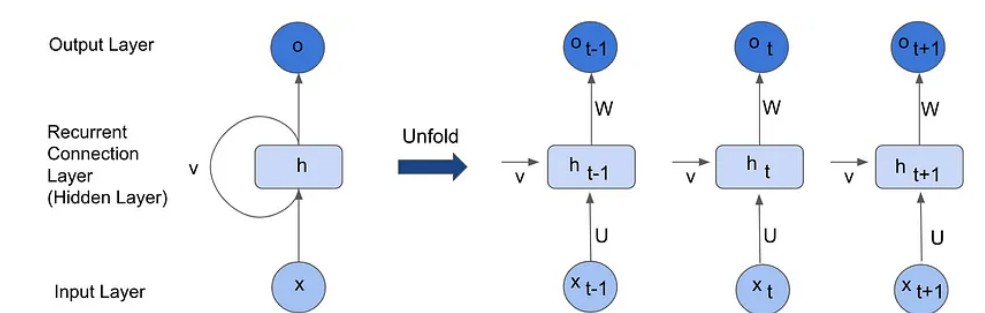

递归神经网络(RNN)是一种特殊类型的神经网络,专门设计用来处理顺序数据。它的基本构架与传统神经网络的架构相似,包括输入层、隐藏层和输出层,但在隐藏层的设计上却有所不同。RNN通过在隐藏层中引入循环连接,使得网络可以在处理每一个输入的时候,参考之前的状态,从而保持上下文。

RNN的魅力在于它的记忆能力——它能够在每一个时间步长的计算中都引入过去的输入。隐藏状态(或称内部状态)不仅能够携带当前时间的输入信息,同时也记录了过去的信息。这一设计使得RNN在处理语言、音乐或时间序列等数据时,表现得尤为突出。

理解RNN的基本架构对于深入掌握其应用非常重要。在RNN中,输入层通常与时间步长有关,每一个时间步接收一个输入向量,然后通过循环连接将之前的隐藏状态与当前输入结合,从而生成新的隐藏状态和输出。这样的设计逻辑让每个时间步不仅是当前输入的反映,同时也是历史输入的综合结果。

三、RNN的工作原理

在RNN的工作过程中,输入与时间步长的关系扮演着至关重要的角色。每一个时间步长都会接收一个输入向量,这个向量可以通过独热编码(One-Hot Encoding)或词嵌入(Word Embedding)来表示。例如,在自然语言处理中,句子的每个单词可以转化为一个对应的向量,这样不仅便于计算,也保持了词汇之间的层次关系。

在RNN内部,隐藏状态的更新机制至关重要。其核心数学公式为:h(t) = f(Wxx(t) + Whh(t-1) + b)。这里,h(t)代表当前时间步的隐藏状态,x(t)对应当前输入向量,W和b是权重与偏置,加总结果经过激活函数f进行非线性变换,从而形成新的隐藏状态。这一过程使得RNN在每一步中动态更新自身的记忆,充分考虑了时间序列的特性。

最值得注意的是,循环连接机制的引入,让RNN具备了强大的信息传递能力。当前时间步的隐藏状态不仅依赖于当前的输入,还依赖于前一个时间步的隐状态,从而形成了一个反馈机制。这种设计模仿了人类大脑对信息处理的方式,使得机器可以模拟学习与推理行为。

四、RNN的参数选择

对于构建有效的RNN模型来说,参数选择至关重要,特别是隐藏状态的大小。隐藏状态的大小直接影响RNN的学习能力和表达能力。通常情况下,选择隐藏状态的大小应考虑到任务的复杂性、可用的训练数据量以及模型的计算能力等因素。较大的隐藏状态能够捕获更复杂的模式和依赖关系,但同时也会增加计算资源的消耗和训练的难度。

在自然语言处理任务中,输出大小的设定同样关键。以语言建模为例,RNN的目标是在给定前文的情况下,预测下一个单词。为此,输出大小一般设置为词汇表的大小,每个元素对应于一个单词的概率分布。这样的设计确保了模型在每次预测中都能充分利用上下文信息,给出合理的输出。

选择参数时,还需注意避免过拟合和欠拟合的风险。过拟合通常发生在模型过于复杂,隐藏状态过大,而欠拟合则相反,模型的表示能力不足。通过交叉验证与参数微调,能够有效规避这些问题。

五、反向传播时的挑战与解决方案

在RNN的训练过程中,反向传播时间(BPTT)的使用是必要的。BPTT是对经典反向传播算法的扩展,旨在处理RNN中的循环连接。通过展开网络,将RNN表示为一系列时间步的网络图,BPTT能够有效计算每个参数在损失函数中的影响。

RNN的训练过程中总会遇到一些挑战,尤其是梯度消失与梯度爆炸。这两种现象都可能导致RNN在训练过程中性能下降,甚至无法收敛。梯度消失问题通常发生在通过多个时间步传播梯度时,导致信息丢失,使得模型难以捕获长时间依赖关系。而梯度爆炸则会使更新步伐剧烈,导致训练过程不稳定。

为了解决这些问题,我们可以采用几种策略。首先,梯度削波(Gradient Clipping)是一种常见的技术,将梯度值限制在一个预设范围内,防止梯度过大造成的更新不稳定。其次,使用具有门控机制的RNN架构,例如LSTM(长短时记忆网络)和GRU(门控递归单元),可以有效捕捉长期依赖的同时,减轻梯度消失的问题。

这些方法的结合应用,可以在实际训练中保证RNN的收敛性和性能,给出更理想的效果。

六、应对梯度消失与爆炸的策略

针对梯度消失与爆炸的挑战,多种技术与方法正在不断被探索。其中梯度削波是一种非常有效的解决方案。当发现梯度的模长超过设定的阈值后,可以将其缩放到合适范围,从而防止参数的剧烈变化,使训练过程更加稳定。

另一个解决方案是采用更合适的权重初始化策略。良好的初始化能够确保网络在最初阶段的学习更加平稳,从而降低梯度消失和爆炸发生的概率。例如,利用Xavier或He初始化算法,可以为网络设置合理的初始权重。

对于更复杂的序列依赖关系,使用LSTM和GRU的高级RNN架构显得尤为重要。LSTM网络通过引入记忆单元和多种门控机制(输入门、遗忘门、输出门),使得模型能够有效地控制信息流动,适应长时间序列学习的需求。GRU则在架构上有所简化,但在许多任务上效能相当甚至更优。

可以通过实验不同的算法和超参数配置,找到最适合应用场景的训练模型,大幅提升RNN处理顺序数据的能力。

七、实际应用中的RNN

在现实世界的案例中,RNN已被广泛应用于多个领域,展现出其强大的潜力。在自然语言处理方面,RNN被用于机器翻译、文本生成和语音识别等任务。例如,谷歌的神经机器翻译系统就采用了RNN架构,极大提升了翻译的质量和效率。

金融领域同样充分利用RNN进行时间序列预测。例如,许多量化交易策略借助RNN分析历史价格数据,预测未来趋势,从而做出相应的交易决策。在这一领域,RNN能够有效捕捉市场的短期波动和长期趋势,为投资者提供更加精准的决策依据。

再比如在音乐生成方面,RNN的应用也越来越广泛。有些艺术家甚至创建了基于RNN模型的曲谱生成工具,利用RNN捕捉曲调的节奏和风格,自动生成新颖的乐曲,大大丰富了音乐创作的可能性。

八、未来的探索与发展

随着越来越多的研究者和工程师将目光投向RNN及其变体,我们有理由相信,未来的RNN技术会不断进步。尤其是在处理长序列依赖和复杂数据结构的能力上,相较于以往,RNN模型会在准确性和效率上都有显著提升。结合最新的深度学习框架的更新与优化,RNN必将在更多实际应用中发挥重要作用。

研究者们也需要探索更高效的算法及其优化,以应对大规模数据下的训练挑战,这将是一个不断演变且充满机遇的领域。

欢迎大家在下方留言讨论,分享您的看法!