Transformer 能否抗噪?探索差分 Transformer 的惊人潜力!

标题:Transformer 能否抗噪?探索差分 Transformer 的惊人潜力!

亲爱的读者朋友们,今天我们要深入探讨的是Transformer模型及其变体——差分Transformer。它不仅在人工智能领域引燃了新的希望,还可能改变我们处理大规模数据的方式。接下来,让我们一起揭开差分Transformer的神秘面纱,看看它是如何拔掉“噪声”的,而这背后又蕴含了怎样的技术创新。

一、引言

在现代的技术世界中,灵魂通过减法而成长不仅是哲学的思考,还是科技进步的一部分。Transformer,这个被誉为人工智能史上最成功的模型之一,展现出了超强的算法能力,尤其是在自然语言处理领域。然而,随着数据量与上下文的快速增长,传统的Transformer在处理长上下文及对噪声的抵抗力方面却显得捉襟见肘。

我们常常不禁要问,在面对比以往更复杂的数据环境时,不仅仅是计算能力的提升,如何让模型更智能地学习?答案或许藏在了差分Transformer的研究之中。接下来,将为大家一一解析它的局限性及未来的希望。

二、Transformer 的局限性

Transformer的核心机制是其注意力机制,能对输入序列中的不同部分进行加权,帮助模型理解上下文关系。然而,这一机制也并非完美,无论是计算时的复杂度还是噪声处理的敏感度,均为当前模型的发展带来了障碍。具体来说:

2.1 Transformer的设计初衷是处理大量数据,但在上下文过长时,注意力的分配并非均匀。大部分计算资源往往集中在不必要的上下文信息上,导致了有用信息的稀缺性和处理的低效率。

2.2 计算成本也成了一个重要因素,尤其是当我们面对更大规模的数据集时,传统Transformer需要的计算量迅速攀升。在许多实际应用场合,比如实时翻译、智能客服,该问题的存在使得应用变得极其困难。

2.3 此外,噪声对模型的影响也愈发显著,当输入中夹杂着大量无关信息时,模型无法有效地提取关键信息,导致决策失误。正如一个人在嘈杂的环境中试图听懂别人说话,这简直是对抗倒退。

三、研究背景与问题探讨

新的研究总是基于旧的基础进行创新。想要改变这一现状,首先需要理解Transformer在处理信息时所存在的问题:

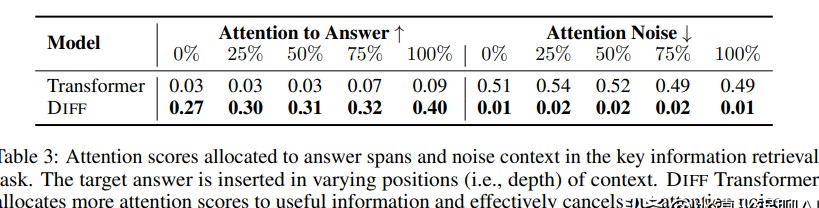

3.1 过度关注不相关信息,使得模型无法寻找到真实的、有意义的信息。这意味着,模型的注意力并未集中在真正需要的地方,反而是被复杂的上下文喧嚣淹没。

3.2 注意力噪音,这一概念的提出标志着对Transformer局限性的深度剖析。噪音不仅影响模型的运行速度,还降低了其准确性。因此,如何减轻这种噪声成为近几个研究的重要方向。

3.3 研究者们试图为此找到解决方案,通过整合不同的技术以及算法,设想了一种改进的算法,这便是差分Transformer。它以降低注意力噪音、提高关注效率为核心出发点,试图解决现存模型的问题。

四、差分 Transformer 的提出

差分Transformer的核心理念是基于对Transformer现有机制的改良,以下几个方面尤为重要:

4.1 差分Transformer通过引入一种新型的差分注意力机制,将传统计算中对同一数据点的注意力分配细分为多个部分,使得模型在计算注意力时更精准,能够有效过滤掉噪声。

4.2 这一机制的灵感其实可以追溯到电气工程中的差分放大器,利用信号之间的差异达到消除干扰的效果。结合这一原理,差分Transformer能够实现更高效的信息提取。

4.3 在该机制的支持下,模型能够迅速适应输入中的变化,更加聚焦于重要信息而非次要信息,从而在处理任务时表现得更加智能。此外,研究表明通过可调的λ因子进一步增强了模型的灵活性与精准度。

五、模型表现与关键实验

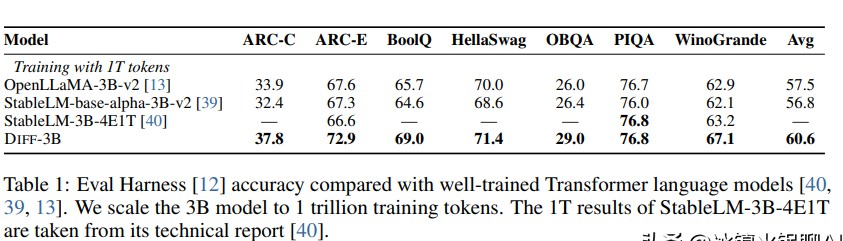

5.1 为验证这种改进,研究者们利用1T个令牌对一个3B参数的差分Transformer模型进行了训练。实验结果显示,该模型在许多标准体检上都表现得优于同规模的传统Transformer。

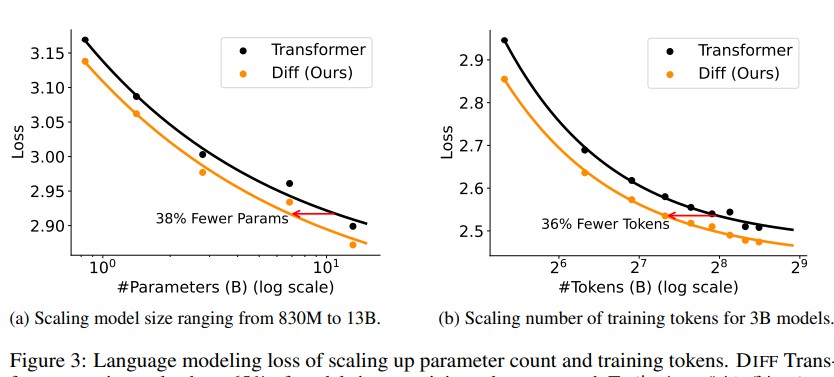

5.2 和传统Transformer相比,差分Transformer在计算资源的使用上表现得更为高效。需要更少的令牌或更少的参数便能够达到相似甚至更好的性能,要知道,这在实际应用中意味着巨大的成本节约。

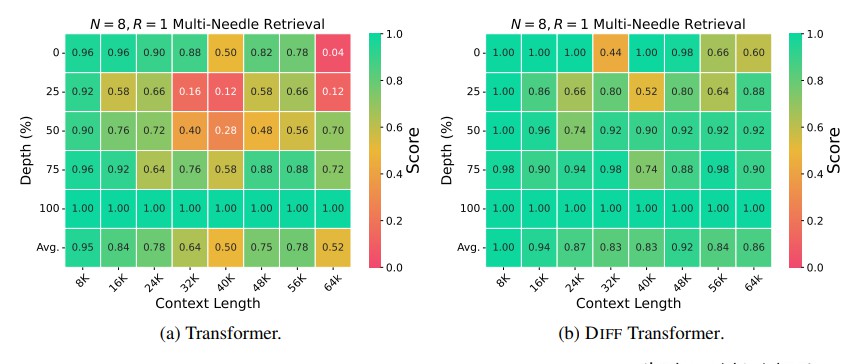

5.3 此外,新模型在处理长上下文时的稳定性也显著增强。研究表明,随着上下文数据量的增加,差分Transformer的表现持续维持在一个稳定的水平,避免了性能随着上下文的增长而发生下降的问题。

六、情境学习与上下文幻觉的研究

情境学习在语言模型中被视为一项极其重要的技能,尤其是在诸如文本摘要、对话生成等任务中表现得尤为突出。

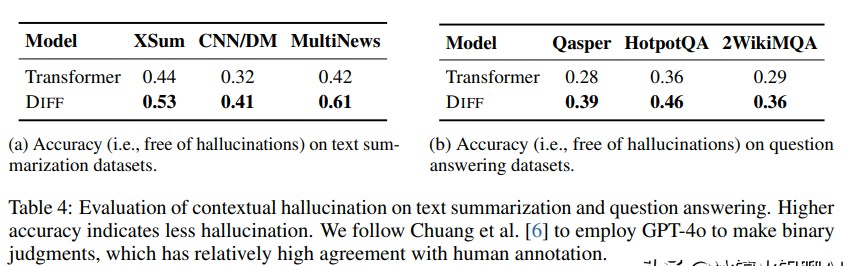

6.1 在这方面,DIFF对多样本分类和上下文学习的影响不容忽视。研究者表明,DIFF在每个数据集上的表现都大幅超过了传统Transformer,这一结果让人振奋。

6.2 上下文幻觉是指输入上下文中存在正确事实但模型依然无法产生准确输出的情况。通过引入新的差分Transformer机制,该模型在处理幻觉时展现出更强的抵抗力,给予了未来研究方向新的启示。

6.3 研究结果表明,DIFF Transformer在应对上下文幻觉方面的表现显著优于目前主流的Transformer模型,对于任务所需的基本信息的关注度也大幅提升。这一结果让模型在处理信息时变得更加高效,极大限度地减少了无谓的计算。

七、研究成果与启示

7.1 差分Transformer显现出的效果是显而易见的,不仅是对注意力噪声的一种有效减轻,更是对信息处理能力的大幅提升。从多个数据集中来看,DIFF Transformer的表现可谓傲视群雄,持续高效。

7.2 未来的研究可借鉴这一模型,探索更多改良,以及可能引入更多的新结构与机制。关注真正相关的信息、减少计算资源消耗,也正是未来人工智能发展的重要目标之一。

7.3 此外,随着对处理长上下文和复杂数据能力的不断增强,差分Transformer的应用场景或将进一步扩大,从而预计将推动相关领域的创新进程。

八、结论

Transformer和差分Transformer在模型设计与应用上存在着显著的区别,这为我们提供了诸多启示。在面对日益复杂的数据环境时,关注降噪与精确计算的能力无疑是推动技术进步的重要下一步。模型的每一番改进都意味着大众需求的不断演变,也预示着人工智能技术在各行各业中有着更广阔的前景。

欢迎大家在下方留言讨论,分享您的看法!