谷歌新推出的SAIF工具,如何保证你的AI安全?

谷歌新推出的SAIF工具,如何保证你的AI安全?

亲爱的读者朋友们,近年来,人工智能的迅速发展为各个领域带来了机遇性的变化,但随之而来的安全隐患也让人捏了一把汗。无论是深度学习模型的数据中毒问题,还是生成性AI带来的道德争议,这些都成了我们需要认真对待的安全挑战。谷歌最近推出的SAIF风险评估工具,正是为了帮助开发者更好地识别和解决这些潜在风险。在这篇文章中,我们将深入探讨SAIF工具的各个功能及其应用场景,为确保人工智能系统的安全与可靠提供参考。

一、引言

谷歌的SAIF风险评估工具是应对日益复杂的AI安全挑战的一项重要措施。这款工具的推出不仅旨在帮助AI开发者和组织评估其安全态势,更重要的是帮助他们识别潜在的风险和实施更强的安全措施。随着人工智能在各个领域的广泛应用,如何安全地构建和部署AI模型成为了行业内亟待解决的问题。SAIF框架的创建和这款新工具的推出,正是针对这一需求而来。

二、SAIF框架的基础

1.1. SAIF的由来

去年的安全人工智能框架(SAIF)引起了行业的广泛关注和讨论。该框架的设计初衷是为用户提供一套系统性的指导,帮助他们安全、负责任地部署AI模型。随着AI技术的渗透,传统的安全措施已显得力不从心,SAIF应运而生,致力于制定出最佳实践和框架,使得安全成为AI开发的首要任务。

1.2. SAIF的关键内容

SAIF不仅仅是一个理论框架,它花了大量精力收集行业内最佳实践,并为组织提供了一整套安全设计的标准。这些标准包括数据安全、模型的可解释性、对抗性攻击的防范等。例如,SAIF建议开发者在模型训练阶段就考虑如何对抗数据中的噪声,从而增加模型的健壮性。同时,SAIF还提出了构建可持续的AI安全治理结构的建议,以确保安全措施不被忽视。

三、共建安全人工智能联盟(CoSAI)

2.1. 合作的必要性

在当今的数字时代,单打独斗的做法已经不再有效。不同企业和组织在AI安全领域面临的挑战是相似的,因此合作愈加重要。谷歌与行业伙伴共同成立的安全人工智能联盟(CoSAI)正是这一背景下的产物。通过合作,成员可以交换经验、分享知识以及共同开发工具,以应对复杂的AI安全问题。

2.2. 联盟的角色与目标

CoSAI的目标不仅是推动行业中的AI安全标准,还希望通过建立统一的沟通平台,促进信息的自由流动和技术的共享。例如,成员企业可以定期举行研讨会和技术交流会,以探讨最新的安全技术和案例。其中,一些企业分享了如“对抗训练”的成功案例,通过不断调整和优化训练过程,提高了自身模型面对攻击的抵抗能力。

四、SAIF风险评估工具的功能

3.1. 工具的基本结构与使用方式

SAIF风险评估工具的设计简明易懂,用户可以通过简单的问卷形式快速评估他们AI系统的安全性。用户在访问SAIF.Google网站时,只需回答一系列关于其AI系统的问题,工具便会自动生成一份定制化的检查清单。这种形式使得用户在评估过程中更能清晰地了解自身系统的潜在风险。

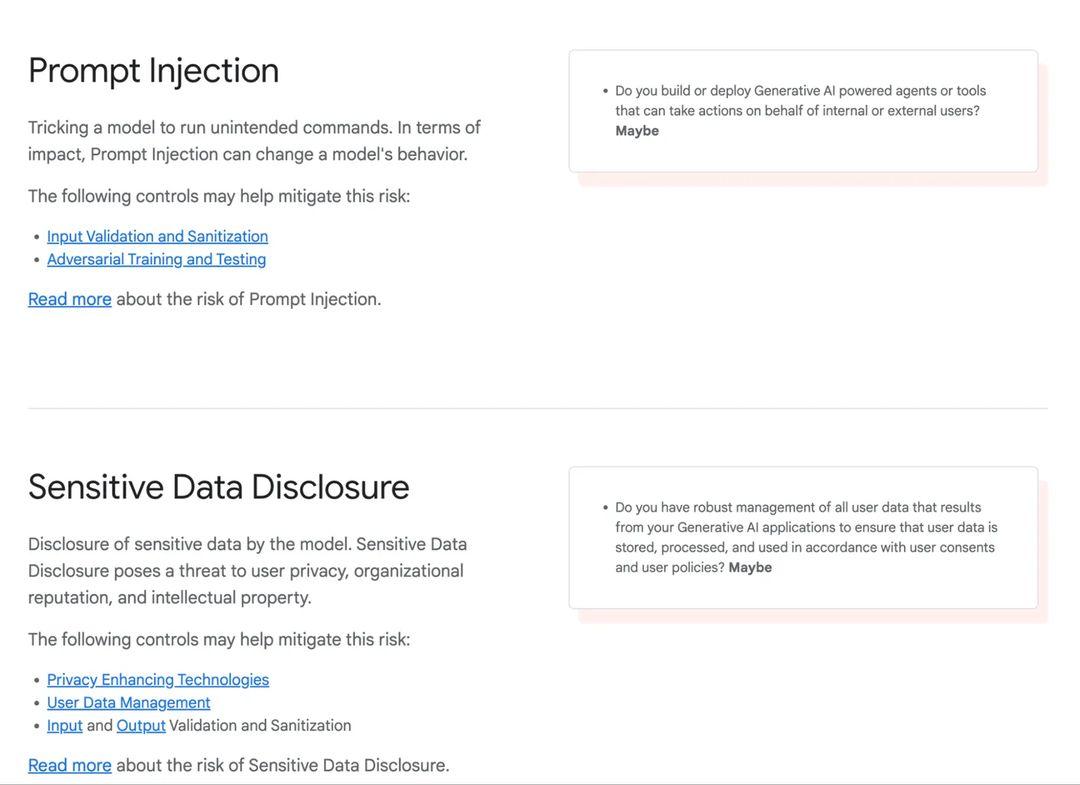

3.2. 风险评估的核心主题

工具涵盖多个关键主题,如:

- AI系统的训练与评估:强调在训练阶段进行多样化的数据处理以防止模型过拟合。

- 模型和数据集的访问控制:引导开发者使用分层权限管理,有效隔离非授权用户的访问。

- 防止攻击与对抗性输入:建议应用如生成对抗网络(GAN)等技术,测试模型在异常输入下的表现。

- 生成性AI的安全框架:提醒开发者要关注生成内容的可控性与使用道德责任。

五、风险识别与缓解

4.1. 风险报告生成

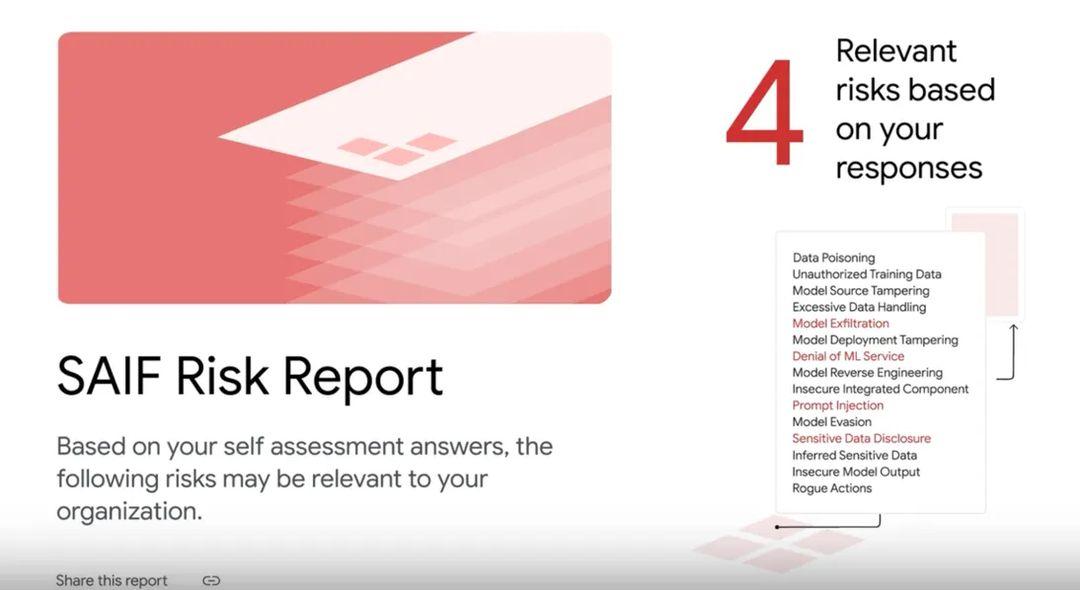

用户在完成问卷后,SAIF风险评估工具将生成一份详细的风险报告。这份报告不是仅仅列出风险,而是精准地突出了AI系统面临的具体挑战。例如,数据中毒问题常见于金融科技领域,模型在训练过程中容易接受到不当的输入,从而导致决策失误。这份报告还会提供针对性且实用的建议。

4.2. 风险解释与缓解策略

每个识别出的风险都会附带详细的解释和建议的缓解措施。这些措施可能包括技术手段和管理策略两部分,例如,为应对“提示注入”的风险,工具可能会推荐对输入进行严格的预处理,来过滤掉恶意输入的可能性,同时加强模型的监控机制,以便及时发现异常。

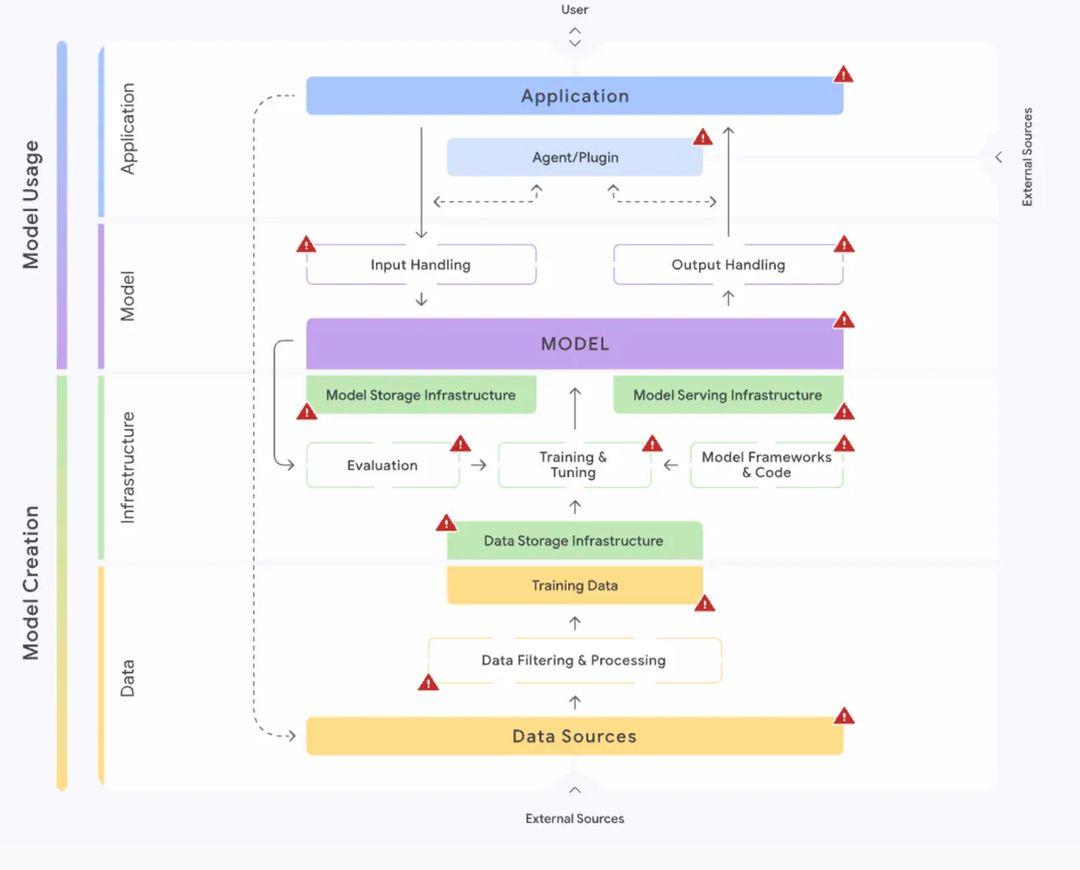

4.3. 互动SAIF风险地图

互动SAIF风险地图的推出,为用户提供了一个可视化的风险管理工具,以便直接了解在AI开发过程中如何引入和缓解不同的安全风险。这张地图通过分类和标记各种风险,使得开发者能够一目了然,快速找到适合自己系统的安全措施。不同的路径和策略可以帮助他们系统化地应对潜在的安全威胁。

通过SAIF风险评估工具,谷歌将AI安全的研究与应用带入了一个新阶段,推动行业朝着更安全、更可靠的方向发展。希望读者在面对AI技术的机遇与挑战时,能够像谷歌一样,不断寻求创新和安全的平衡,确保自身业务的可持续发展。

欢迎大家在下方留言讨论,分享您的看法!