大模型智能回复神器!小红书抖音快手通吃!

使用大模型自动回复社交评论:RAG技术揭秘与实战

在当下这个数字化时代,社交媒体已经深入到我们生活的每一个角落。小红书、抖音、快手等平台上的海量评论,是用户与品牌互动的重要桥梁。然而,面对如此庞大的评论量,如何快速、准确地回复每一条评论,成为了许多品牌和企业面临的难题。幸运的是,随着人工智能技术的飞速发展,大模型(Large Language Models, LLMs)为我们提供了解决这一问题的新思路。今天,就让我们一起走进大模型的世界,探讨如何通过RAG(Retrieval-Augmented Generation)技术优化LLMs,实现自动回复社交评论的神奇之旅。

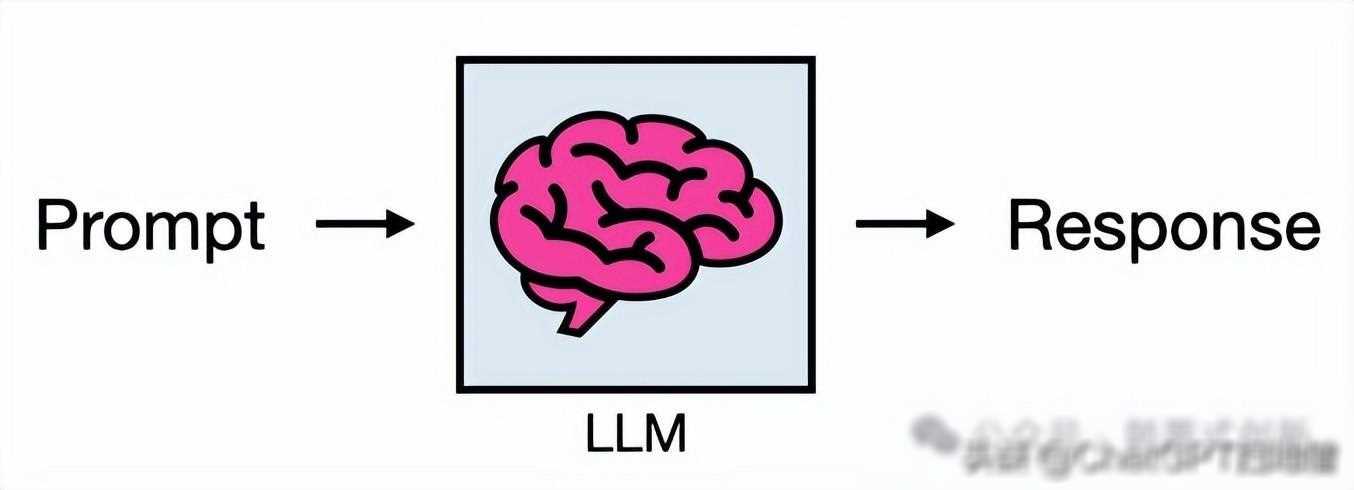

大模型,如GPT系列、BERT等,以其庞大的参数规模和强大的自然语言处理能力,成为了当下最热门的人工智能技术之一。它们能够存储和部署大量知识,以响应用户查询,为我们带来了诸如gpt这样的强大AI系统。然而,大模型也面临着一些挑战。首先,它们的知识是静态的,无法随着新信息的出现而更新。其次,大模型对于小众和专业信息的理解能力相对较弱,可能会导致对用户查询产生不良甚至虚构的响应。

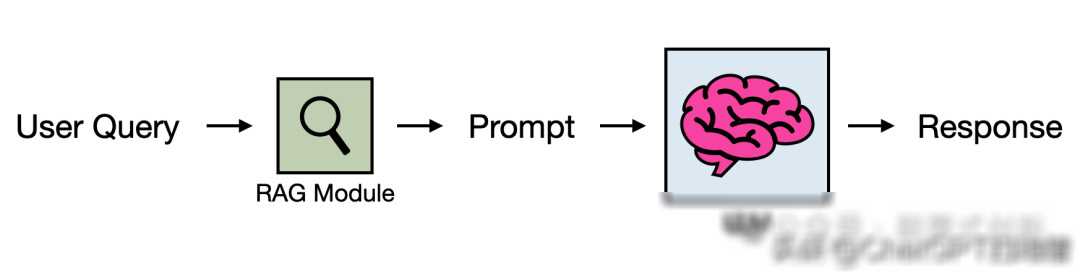

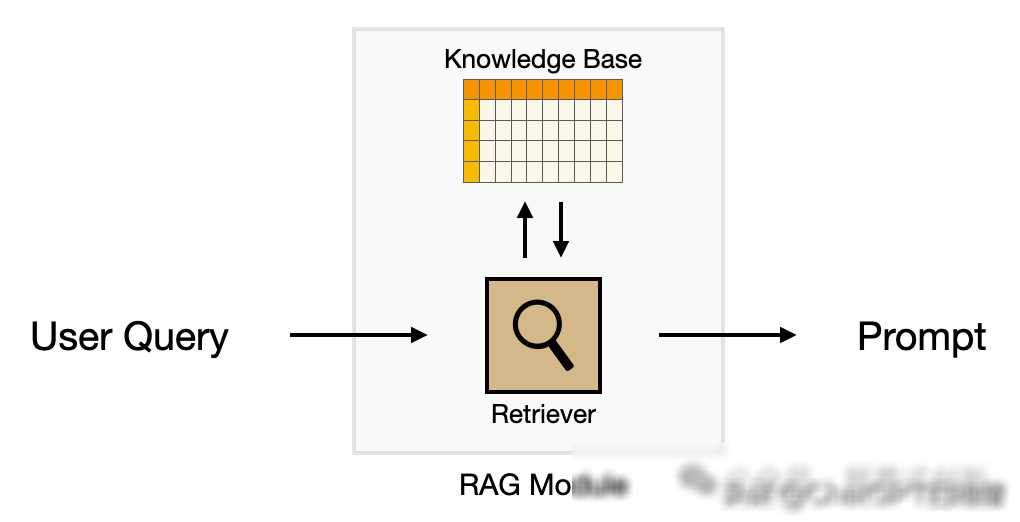

为了克服大模型的这些局限性,研究者们提出了RAG技术。RAG,即检索增强生成,是一种将外部知识库与大模型相结合的方法。通过检索器从知识库中提取与用户查询相关的信息,并将其注入到提示中,再传递给大模型进行生成。这样一来,大模型就能够利用外部知识库中的最新、最准确的信息来回答用户的问题,大大提高了回答的质量和准确性。

那么,在实际应用中,我们如何利用RAG技术来实现自动回复社交评论呢?以下是一个简单的实战案例。

首先,我们需要准备一个包含品牌相关信息的知识库。这个知识库可以包括产品介绍、使用说明、常见问题解答等内容。我们可以将这些内容以文档的形式存储在数据库中,以便后续进行检索。

接下来,我们需要构建一个能够从知识库中检索相关信息的检索器。这个检索器可以使用文本嵌入技术来计算用户查询与知识库中每个项目之间的相似度分数,从而找出与用户查询最相关的项目。具体实现时,我们可以使用诸如Elasticsearch、Lucene等搜索引擎技术来构建检索器。

一旦我们有了检索器和知识库,就可以将它们与大模型进行集成了。当接收到用户评论时,我们首先使用检索器从知识库中检索相关信息,并将这些信息注入到提示中。然后,我们将增强后的提示传递给大模型进行生成,得到最终的回复内容。

通过RAG技术,我们不仅能够解决大模型知识静态和理解能力有限的问题,还能够实现快速、准确地回复社交评论。与传统的自动回复系统相比,RAG技术具有以下优势:

实时更新:由于使用了外部知识库,RAG技术能够实时地获取最新的品牌信息,确保回复内容的准确性和时效性。

个性化回复:通过检索与用户查询最相关的信息,RAG技术能够实现个性化回复,提高用户满意度和忠诚度。

可扩展性:RAG技术具有很好的可扩展性,可以轻松地扩展到其他社交媒体平台和语言环境中。

展望未来,随着大模型技术的不断发展和完善,RAG技术将在自动回复社交评论领域发挥越来越重要的作用。我们可以预见,在不久的将来,RAG技术将成为品牌和企业自动化客户服务的重要工具之一。

在数字化时代,社交媒体已经成为了品牌与用户互动的重要渠道。如何快速、准确地回复用户评论,成为了品牌和企业面临的重要挑战。通过RAG技术优化大模型,我们不仅能够解决大模型的局限性,还能够实现自动回复社交评论的神奇之旅。让我们一起期待RAG技术在未来的更多应用和发展吧!