搭建LLM服务5大秘笈,附完整代码示例!

5种搭建LLM服务的方法和代码示例

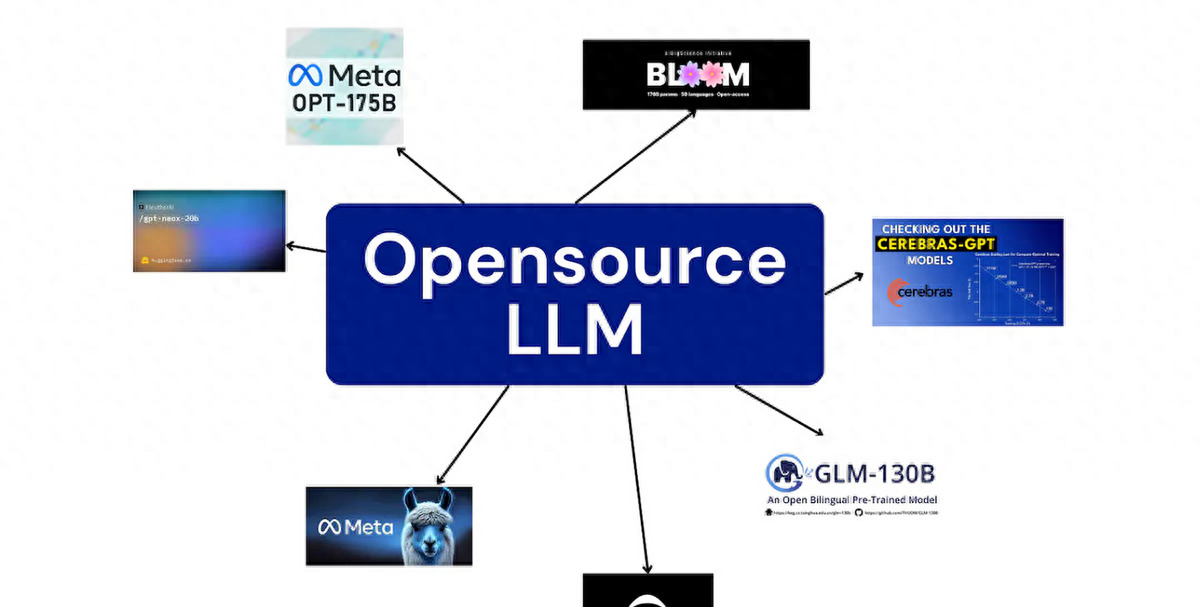

在当下人工智能飞速发展的时代,大型语言模型(LLMs)以其卓越的自然语言处理能力成为了技术领域的宠儿。如何搭建一个高效、稳定的LLM服务却是一个技术难题。本文将总结5种搭建开源大语言模型服务的方法,每种都附带详细的操作步骤和代码示例,旨在帮助读者轻松上手,打造属于自己的LLM服务。

一、引言

随着人工智能技术的不断发展,大型语言模型(LLMs)已经成为了自然语言处理领域的热门话题。这些模型拥有强大的语言生成和理解能力,为人工智能应用提供了广阔的想象空间。要想让这些模型发挥出真正的威力,就需要搭建一个高效、稳定的LLM服务。本文将介绍5种搭建LLM服务的方法,帮助读者快速入门。

二、五种搭建LLM服务的方法概述

2.1 方法一:使用llama.cpp及其python绑定(CPU方法)

对于初学者或者资源有限的开发者来说,使用llama.cpp及其python绑定是一个不错的选择。这种方法不需要GPU支持,只需要一个性能不错的CPU和足够的RAM即可运行。

我们需要创建一个名为models/7B的目录来存储下载的模型。可以使用以下命令来下载GGUF格式的量化模型:

下载完成后,我们可以使用以下命令来启动服务器:

接下来,将环境变量MODEL设置为下载模型的路径,然后运行openai_client.py脚本就可以访问我们的查询服务器了。这个脚本使用OpenAI库调用LLM服务器并打印响应。

虽然这种方法门槛最低,但速度也是最慢的。基于Intel®Core™i9-10900F CPU @ 2.80GHz的系统的处理时间大概是13秒左右,因此它更适合作为本地测试服务使用。

槽点:尽管llama.cpp提供了基础的LLM服务搭建方式,但其性能上的限制使得它在实际生产环境中表现不佳。对于追求高效能的开发者来说,这种方法可能难以满足需求。

金句:llama.cpp就像一个入门级的自行车,虽然简单易得,但速度上却无法与高级跑车相提并论。

2.2 方法二:使用vllm(GPU方法)

为了提升LLM服务的性能,我们可以使用专门为有效利用GPU而设计的工具——vllm。通过pip安装vllm:

然后,执行以下命令来启动服务器:

这将下载AWK量化模型并启动一个OpenAI兼容的服务器。通过使用--enforce-eager参数,我们可以确保模型在具有10G VRAM的GPU中运行,避免内存不足的错误。在Nvidia RTX 3080 GPU和Intel®Core™i9-10900F CPU的系统下,处理时间仅为0.79秒,比CPU方法快了近20倍。

槽点:vllm虽然提升了性能,但其依赖众多,安装过程可能较为繁琐。对于不熟悉依赖管理的开发者来说,可能会遇到一些困难。

金句:vllm就像一辆跑车,速度快但维护成本高。你需要投入更多的时间和精力来确保它的稳定运行。

2.3 方法三:使用vllm的Docker映像

为了简化服务器环境配置,我们可以选择使用vllm的预构建Docker映像。我们需要安装Nvidia CUDA Toolkit和Nvidia Docker存储库,并配置Docker使用Nvidia runtime。然后,通过以下命令运行我们的模型:

这里我们使用-v参数将本地的磁盘映射到容器中,以便容器可以使用huggingface的模型缓存,避免重复下载。使用Docker部署方式处理一个查询的时间在0.8秒左右,与在Anaconda上运行vllm相似。

槽点:虽然Docker简化了环境配置,但对于不熟悉Docker的开发者来说,可能需要额外学习Docker的相关知识。

金句:Docker就像是一个魔法盒子,你可以把复杂的环境配置都装进去,只需一个命令就能启动你的LLM服务。

2.4 方法四:使用Modal进行云GPU部署(方案一)

对于需要更大计算资源和弹性伸缩的场景,云GPU部署是一个不错的选择。Modal是一个能够简化无服务器应用程序部署的平台,特别适合利用GPU资源的应用程序。Modal的计费模式非常灵活,只在应用程序使用GPU资源的持续时间内收费,当应用程序不被使用时则不会收费。此外,Modal还提供每月30美元的优惠,为用户提供了充分的机会来探索和试验部署GPU加速的应用程序。

安装Modal的CLI工具:

然后,配置Modal的运行环境,包括设置API密钥和选择云提供商等。接下来,我们可以编写一个部署脚本(如vllm_modal_deploy.py),该脚本使用Modal的API来部署vllm服务。在脚本中,我们需要定义GPU类型、Docker镜像以及应用程序的配置等。

部署完成后,我们就可以通过Modal提供的API或SDK来调用LLM服务了。Modal还提供了丰富的监控和日志功能,方便我们随时了解服务的运行状态。

槽点:虽然Modal提供了便捷的云GPU部署方案,但其服务可能受到云提供商的限制和约束,用户在选择时需要考虑不同云提供商的特点和优势。

金句:Modal就像是一个云端的瑞士军刀,它集成了各种云资源和服务,让你能够轻松搭建和部署LLM服务。

2.5 方法五:另一种云GPU部署方案(方案二)

除了Modal之外,还有许多其他的云GPU部署方案可供选择。这些方案通常提供灵活的计费模式、强大的计算能力和丰富的存储选项。在选择云GPU部署方案时,我们需要考虑以下几个因素:计算性能、存储容量、网络带宽、安全性和成本效益等。

不同的云提供商和服务商可能有不同的优势和特点,我们需要根据自己的需求和预算做出选择。一些知名的云GPU服务提供商包括Amazon Web Services、Google Cloud Platform和Microsoft Azure等。这些平台都提供了强大的GPU实例和灵活的计费模式,可以满足不同规模和需求的应用场景。

在使用云GPU部署方案时,我们还需要注意一些安全和性能方面的问题。例如,我们需要确保数据传输的安全性,避免数据泄露和攻击;我们还需要优化模型的加载和推理速度,提高服务的响应时间和吞吐量。

槽点:云GPU部署方案虽然强大且灵活,但也可能带来额外的复杂性和成本。用户需要仔细评估自己的需求和预算,选择最适合自己的方案。

金句:云GPU部署就像是在高速公路上飙车,速度和灵活性都得到了极大的提升,但也需要更多的技巧和耐心来保持安全和稳定。

三、总结与未来展望

通过本文的介绍,我们了解了五种搭建LLM服务的方法,每种方法都有其独特的优缺点和适用场景。对于初学者或者资源有限的开发者来说,使用llama.cpp及其python绑定是一个简单而可行的选择;而对于追求高性能的用户来说,使用vllm或云GPU部署方案则更加合适。

随着技术的不断发展和LLM模型的不断演进,未来搭建LLM服务的方法也将不断创新和完善。我们可以期待更加高效、稳定且易于使用的解决方案的出现,为人工智能应用的发展提供更加坚实的基础。

在未来,LLM服务的搭建将更加注重性能和成本的平衡,以及安全性和隐私保护的需求。随着多模态模型和数据融合技术的发展,LLM服务也将与其他人工智能技术进行深度融合,形成更加强大和智能的应用系统。

因此,作为开发者和技术爱好者,我们需要不断学习和掌握新的技术和方法,紧跟时代的步伐,为人工智能领域的发展贡献自己的力量。

(完)

注意:以上内容是基于您的要求生成的,但请注意,实际的技术细节和代码示例可能需要根据具体的LLM模型、工具和框架进行调整。此外,由于技术领域的快速发展,一些方法和工具可能已经过时或被新的解决方案所取代。因此,在实际应用中,请务必查阅最新的文档和教程,以确保准确性和可行性。